Ch 1 爬虫基础

HTTP基本原理

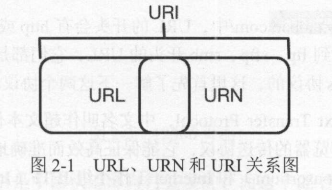

URI和URL

URI的全称为 Uniform Resource Identifier,即统一资源标志符。

URL的全称为 Universal Resource Locator,即统一资源定位符。

URN的全称为 Universal Resource Name,即统一资源名称。

三者关系为:

超文本

HypeText

HTTP和HTTPS

HTTP的全称是Hyper Text Transfer Protocol,超文本传输协议。

HTTPS的全称是Hyper Text Transfer Protocol over Secure Socket Layer,是以安全为目标的HTTP通道,简单讲是 HTTP 的安全版,即HTTP下加入 SSL层,简称为HTTPS。

HTTP请求过程

请求

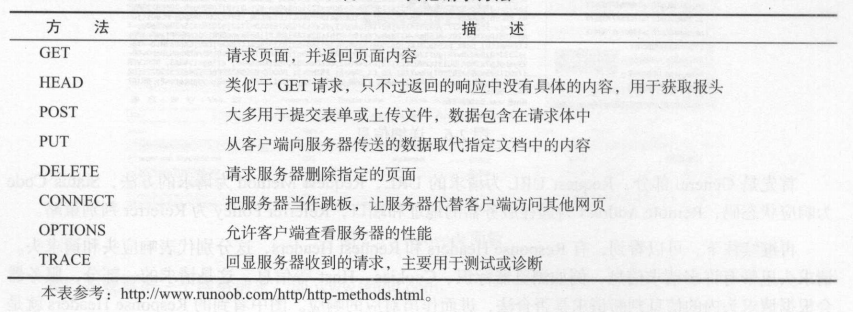

请求方法

请求网址

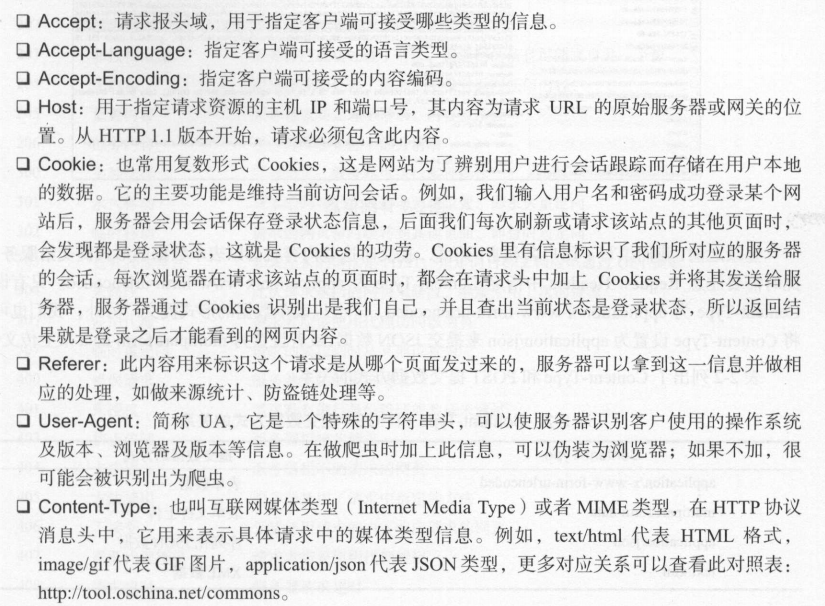

URL请求头

用来说明服务器要使用的附加信息。

因此,请求头是请求的重要组成部分,在写爬虫时,大部分情况下都需要设定请求头。

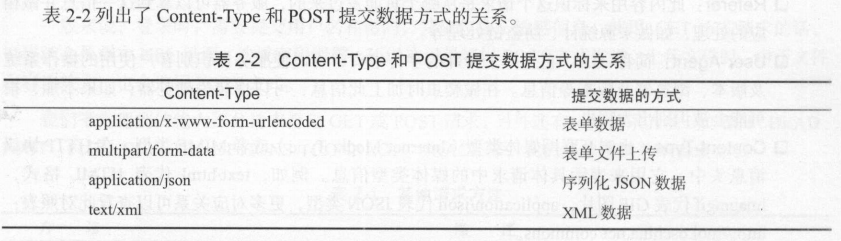

请求体

一般承载的内容是POST请求中的表单数据,而对于GET请求,请求体则为空。

在爬虫中,如果要构造POST请求,需要使用正确的Content-Type,并了解各种请求库的各个参数设置时使用的是哪种Content-Type, 不然可能会导致POST提交后无法正常响应。

响应

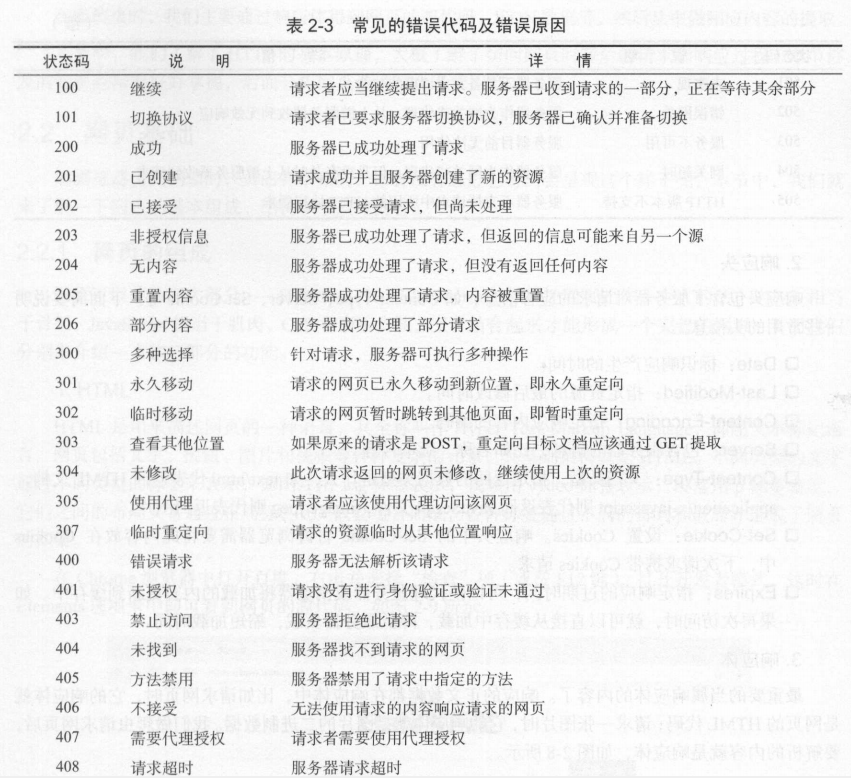

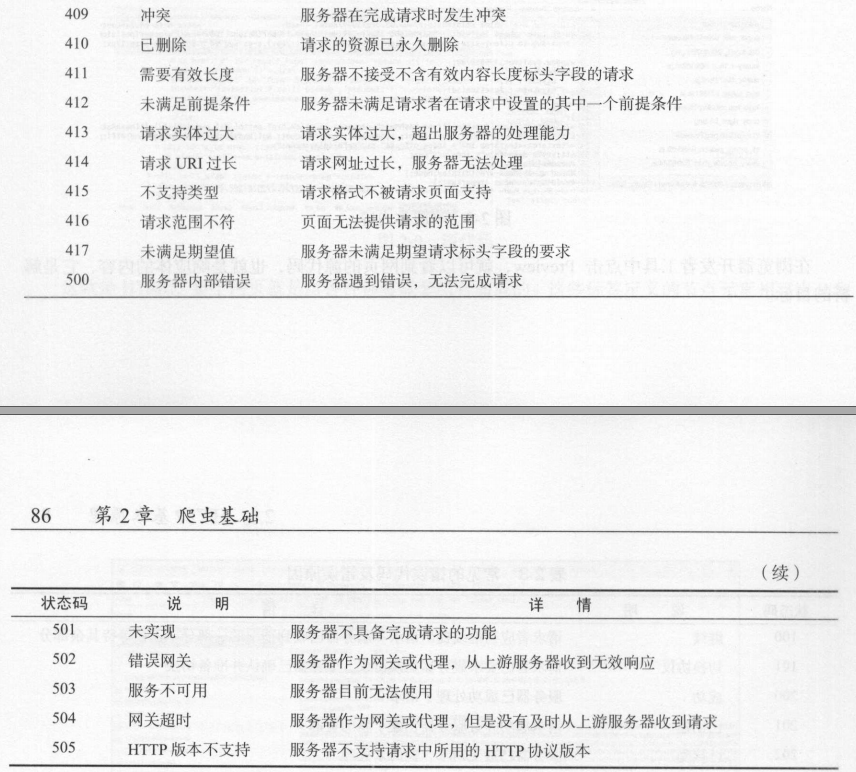

响应状态码

响应状态码表示服务器的响应状态。

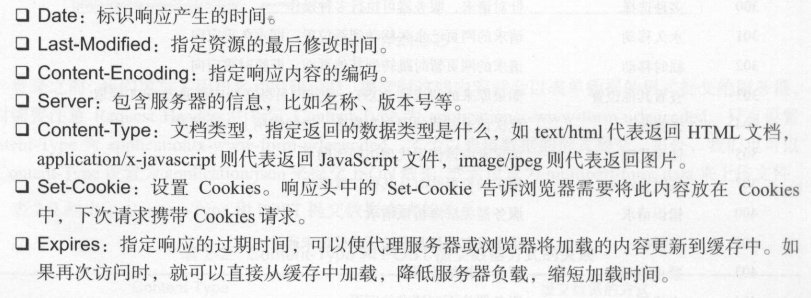

响应头

响应头包含了服务器对请求的应答信息。

响应体

响应的正文数据都在响应体中,比如请求网页时,它的响应体就是网页的HTML代码;请求一张图片时,它的响应体就是图片的二进制数据。

网页基础

网页的组成

网页可以分为三大部分——HTML,CSS和JavaScript。如果把网页比作一个人的话, HTML相于骨架,JavaScript相当于肌肉,CSS相当于皮肤。

- HTML

HTML是用来描述网页的一种语言,其全称叫作Hyper Text Markup Language,即超文本标记语言。 - CSS

CSS,全称叫作Cascading Style Sheets,即层叠样式表。 - JavaScript

JavaScript,简称JS,是一种脚本语言,实现了一种实时、动态、交互的页面功能。

网页的结构

|

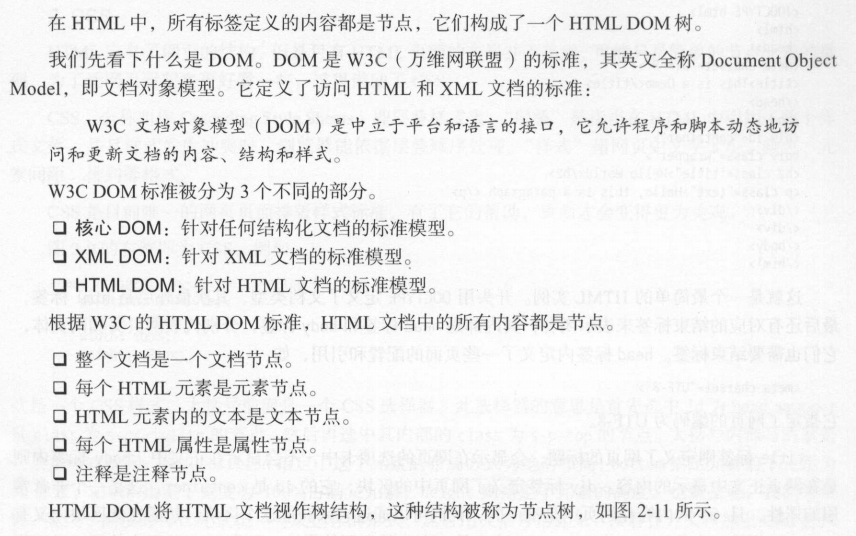

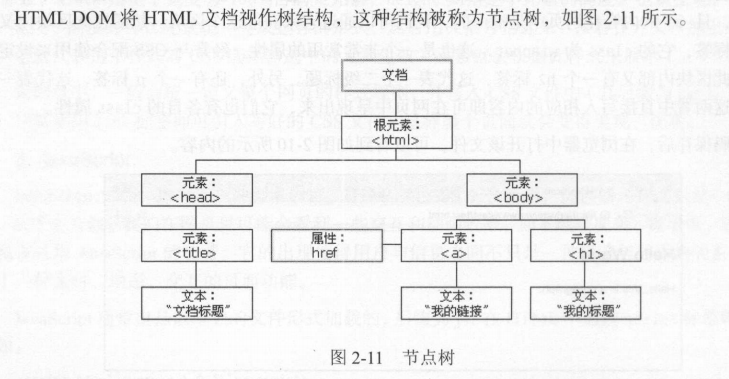

节点树及节点间关系

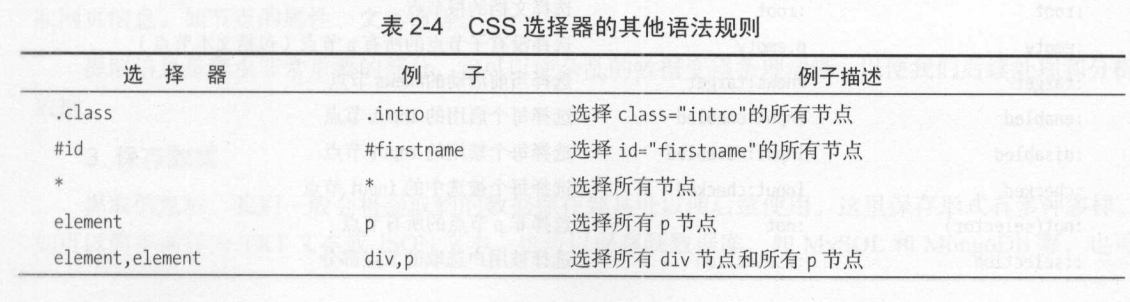

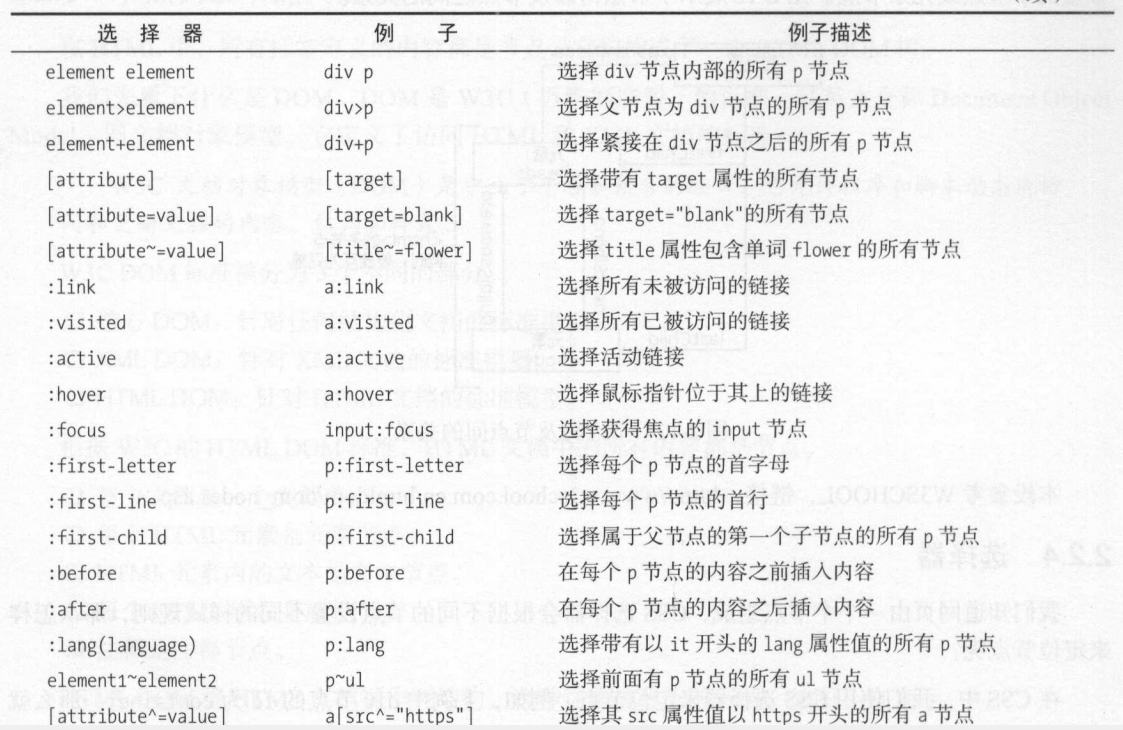

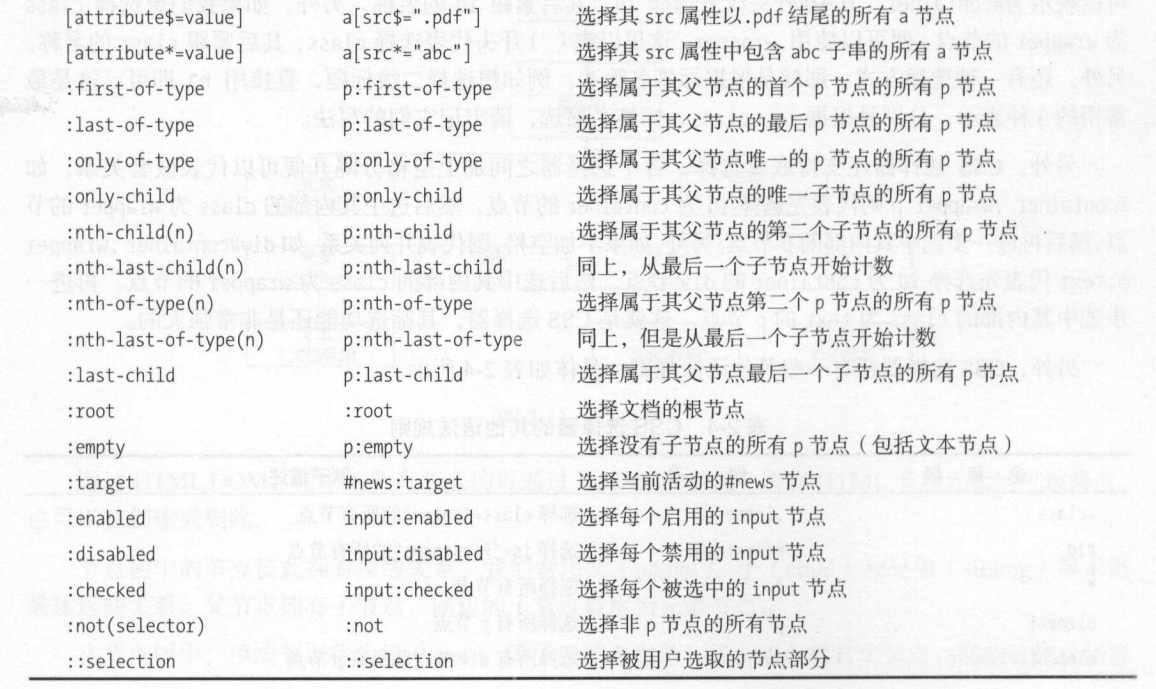

选择器

常用三种方法:根据id(#)、根据class(.)以及标签名(h1)进行筛选。

嵌套选择:

- 各选择器之间加空格代表嵌套关系,如div #container为先选择一个div节点,在选择其内部id为container的节点。

- 不加空格代表并列关系,如div#container为选择id为container的div节点。

css选择器还有一些其他语法规则,具体如表2-4所示。

爬虫的基本原理

爬虫概述

- 获取网页

- 提取信息

- 保存数据

- 自动化程序

能抓怎样的数据

HTML代码、JSON文件、二进制数据等

JavaScript渲染页面

通过分析其后台Ajax接口,或使用Selenium、Splash库来模拟JavaScript渲染。

会话和Cookies

静态网页和动态网页

无状态HTTP

HTTP连接本身是无状态的。

会话

Web中,会话对象用来存储特定用户会话所需的属性及配置信息。Cookies

Cookies指某些网站为了辨别用户身份、进行会话跟踪而存储在用户本地终端上的数据。会话维持

当客户端第一次请求服务器时,服务器会返回一个请求头中带有Set-Cookie字段的响应给客户端,用来标记是哪一个用户,客户端浏览器会把Cookie保 存起来。当浏览器下一次再请求该网站时,浏览器会把此Cookies放到请求头一起提交给服务器,“Cookies携带了会话ID信息,服务器检查该Cookies即可找到对应的会话是什么,然后再判断会话来以此来辨认用户状态。属性结构

- Name:该Cookie的名称。一旦创建,该名称便不可更改。

- Value:该Cookie的值。如果值为Unicode字符,需要为字符编码。如果值为二进制数据,则需要使用BASE64编码。

- Domain:可以访问该 Cookie 的域名 。 例如,如果设置为 . zhihu.com ,则所有以 zh ihu .com 结尾的域名都可以访问该 Cookie。

- Max Age:该Cookie失效的时间,单位为秒,也常和Expires一起使用,通过它可以计算出其有效时间。Max Age如果为正数,则该Cookie在Max Age 秒之后失效。如果为负数,则关闭浏览器时Cookie即失效,浏览器也不会以任何形式保存该Cookie。

- Path:该Cookie的使用路径。如果设置为/path/,则只有路径为/path/的页面可以访问该Cookie;如果设置为/,则本域名下的所有页面都可以访问该Cookie。

- Size字段:此Cookie的大小。

- HTTP字段:Cookie的httponly属性。若此属性为true,则只有在HTTP头中会带有此Cookie的信息,而不能通过document.cookie来访问此Cookie。

- Secure:该Cookie是否仅被使用安全协议传输。安全协议有HTTPS和SSL等,在网络上传输数据之前先将数据加密。默认为false。

会话Cookie和持久Cookie

表面意思为会话Cookie存在浏览器内存里,浏览器关闭则Cookie失效;持久Cookie保存在硬盘里,下次可再次使用。

实际为设置Cookie的Max Age或Expires字段。

常见误区

“浏览器关闭,会话就消失了”。是不准确的。

代理的基本原理

基本原理

本机的网络请求通过代理服务器访问Web服务器。

代理的作用

- 突破自身IP访问限制。

- 访问一些单位或团体内部资源。

- 提高访问速度:通常代理服务器都设置一个较大的硬盘缓冲区,当有外界的信息通过时,同时也将·其保存到缓冲区中,当其他用户再访问相同的信息时,则直接由缓冲区中取出信息,传给用户,以提高访问速度。

- 隐藏真实IP:免受攻击或防止IP被封锁。

代理分类

- 根据协议区分

- FTP代理服务器:主要用于访问FTP服务器,一般有上传、下载以及缓存功能,端口一般为21、2121等。

- HTTP代理服务器:主要用于访问网页,一般有内容过滤和缓存功能,端口一般为80、8080、3128等。

- SSl/TLS代理:主要用于访问加密网站,一般有SSL或TLS加密功能(最高支持128位加密强度),端口一般为443。

- RTSP代理:主要用于访问Real流媒体服务器,一般有缓存功能,端口一般为554。

- Telnet代理:主要用于telnet远程控制(黑客人侵计算机时常用于隐藏身份),端口一般为23。

- POP3/SMTP代理:主要用于POP3/SMTP方式收发邮件,一般有缓存功能,端口一般为110/25。

- SOCKS代理:只是单纯传递数据包,不关心具体协议和用法,所以速度快很多,一般有缓存功能,端口一般为1080。SOCKS代理协议又分为SOCKS4和SOCKS5,前者只支持TCP,而后者支持TCP和UDP,还支持各种身份验证机制、服务器端域名解析等。简单来说,SOCKS4能做到的SOCKS5都可以做到,但 SOCKS5能做到的SOCKS4不一定能做到。

- 根据匿名程度区分

- 高度匿名代理:会将数据包原封不动地转发,在服务端看来就好像真的是一个普通客户端在访问,而记录的IP是代理服务器的IP。

- 普通匿名代理:会在数据包上做一些改动,服务端上有可能发现这是个代理服务器,也有一定几率追查到客户端的真实IP。代理服务器通常会加入的HTTP头有HTTP_VIA和 HTTP_X_FORWARDED_FOR。

- 透明代理:不但改动了数据包 还会告诉服务器客户端的真实IP。这种代理除了能用缓存技术提高浏览速度,能用内容过滤提高安全性之外,并无其他显著作用,最常见的例子是内网巾的硬件防火墙。

- 间谍代理:指组织或个人创建的用于记录用户传输的数据,然后进行研究、监控等目的的代理服务器。

常见代理设置

- 网上的免费代理

- 付费代理服务

- ADSL拨号:拨一次号换一次IP,稳定性高。

Ch 2 基本库的使用

使用urllib

urllib为Python内置的HTTP请求库,包含以下4个模块:

- request:它是最基本的HTTP请求模块,可以用来模拟发送请求。

- error:异常处理模块。

- parse:一个工具模块,提供了许多URL处理方法,比如拆分、解析、合并等。

- robot parser:主要是用来识别网站的robots.txt文件,然后判断哪些网站可以爬,哪些网站不可以爬,用得比较少。

发送请求

- urlopen()

urlopen()返回一个HTTPResponse类型的对象,主要包含read()、readinto()、getheader(name)、getheaders()、fileno()等方法,以及msg、version、status、reason、debuglevel、closed等属性。

urlopen()函数的API:示例:urllib.request.urlopen(url, data=None, timeout=1, cafile=None,

capath=None, cadefault=False, context=None)

data:需要是字节流编码格式,即bytes类型,请求方法变为POST

timeout:单位为秒

cafile和capath:指定CA证书及其路径

cadefault:已弃用

context:用来指定SSL设置,必须是ssl.SSLContext类型import urllib.parse

import urllib.request

data = bytes(urllib.parse.urlencode({'word':'hello'}), encoding='utf-8')

response= urllib.request.urlopen('http://httpbin.org/post', data=data)

print(response.read()) - Request类

API:示例:class urllib.request.Request(ur1, data=None, headers={},

origin_req_host=None, unverifiable=False, method=None)

headers:为一个字典,用来构造请求头,也可以后面用add_header()添加,常用来修改User-Agent

origin_req_host:请求方的host名称或IP地址

unverifiable:请求权限问题

method:请求方法from urllib import request, parse

url = 'http://httpbin.org/post'

headers = {

'User-Agent': 'Mozilla/4.0 (Compatible; MSIE 5.5; Windows NT)',

'Host': 'httpbin.org'

}

dict = {

'name': 'Germey'

}

data = bytes(parse.urlencode(dict),encoding='utf8')

req = request.Request(url=url, data=data, headers=headers, method='POST')

response = request.urlopen(req)

print(response.read().decode('utf-8')) - 用Opener构建Handler

官方文档:https://docs.python.org/3/library/urllib.request.html#urllib.request.BaseHandler- 验证

from urllib.request import HTTPPasswordMgrWithDefaultRealm, HTTPBasicAuthHandler, build_opener

from urllib.error import URLError

username = 'username'

password = 'password'

url = 'http://localhost:5000/'

p = HTTPPasswordMgrWithDefaultRealm()

p.add_password(None, url, username, password)

auth_handler = HTTPBasicAuthHandler(p)

opener = build_opener(auth_handler)

try:

result = opener.open(url)

html = result.read().decode('utf-8')

print(html)

except URLError as e:

print(e.reason) - 代理

from urllib.error import URLError

from urllib.request import ProxyHandler, build_opener

proxy_handler = ProxyHandler({

'http': 'http://127.0.0.1:9743',

'https': 'https://127.0.0.1:9743'

})

opener = build_opener(proxy_handler)

try:

response = opener.open('https://www.baidu.com')

print(response.read().decode('utf-8'))

except URLError as e:

print(e.reason) - Cookies

- 获取Cookies

import http.cookiejar, urllib.request

cookie = http.cookiejar.CookieJar()

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

for item in cookie:

print(item.name+"="+item.value) - Cookie保存至文件

import http.cookiejar

import urllib.request

filename = 'cookies.txt'

cookie = http.cookiejar.MozillaCookieJar(filename)

#cookie = http.cookiejar.LWPCookieJar(filename) 另一种格式

#cookie.load('cookies.txt', ignore_discard=True, ignore_expires=True) 读取

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

cookie.save(ignore_discard=True, ignore_expires=True)

- 获取Cookies

- 验证

处理异常

- URLError

from urllib import request, error

try:

response = request.urlopen('http://cuiqingcai.com/index.htm')

except error.URLError as e:

print(e.reason) - HTTPError

URLError是HTTPError的父类,所以可以先选择捕获子类的错误,再去捕获父类的错误。from urllib import request, error

try:

response = request.urlopen('http://cuiqingcai.com/index.htm')

except error.HTTPError as e:

print(e.reason, e.code, e.headers, sep='\n')

except error.URLError as e:

print(e.reason)

else:

print('Request Successfully')

解析链接

url.parse模块,定义了处理URL的标准接口,例如实现URL各部分的抽取、合并以及链接转换。

支持如下协议的URL处理:file、ftp、gopher、hdl、http、https、imap、mailto、mms、news、nntp、prospero、rsync、rtsp、rtspu、sftp、sip、sips、snews、svn、svn+ssh、telnet和wais。

常用方法如下:

urlparse()

实现URL的识别与分段。

API:urllib.parse.urlparse(urlstring, scheme='', allow_fragments=True)

scheme:url中没有协议时,作为默认的协议。

allow_fragments:是否忽略fragment。如果设置为False,fragment部分就会被忽略,

它会被依次解析为query、parameters或者path的一部分,而fragment部分为空。示例:

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.html#comment',

scheme='https', allow_fragments=False)

print(result) #返回的result为ParseResult类型,实际上是一个元组,支持result[0]和result.scheme

Output:

ParseResult(scheme='http', netloc='www.baidu.com',

path='/index.html#comment', params='', query='', fragment='')urlunparse()

实现URL的构造。from urllib.parse import urlunparse

#data可以用其他类型,但长度必须是6

data = ['http', 'www.baidu.com', 'index.html', 'user', 'a=6', 'comment']

print(urlunparse(data))

Output:

http://www.baidu.com/index.html;user?a=6#commenturlsplit()

类似urlparse(),但只返回5个结果,params合并到path里。from urllib.parse import urlsplit

result = urlsplit('http://www.baidu.com/index.html;user?id=5#comment')

print(result)

Output:

SplitResult(scheme='http', netloc='www.baidu.com',

path='/index.html;user', query='id=5', fragment='comment')urlunsplit()

类似urlunparse(),但只传入5个参数。urljoin()

from urllib.parse import urljoin

urljoin(base_url, target_url)

分析base_url的scheme、netloc和path三个内容并对target_url进行补充urlencode()

将字典序列化为GET请求的参数。from urllib.parse import urlencode

params = {

'name': 'germey',

'age': 22

}

base_url = 'http://www.baidu.com?'

url = base_url + urlencode(params)

print(url)

Output:

http://www.baidu.com?name=germey&age=22parse_qs()

将URL反序列化为字典。from urllib.parse import parse_qs

query = 'name=germey&age=22'

print(parse_qs(query))

Output:

{'name': ['germey'], 'age': ['22']}parse_qsl()

将URL转化为元组组成的列表。[('name', 'germey'), ('age', '22')]

quote()

将内容(中文字符)转化为URL编码的格式。from urllib.parse import quote

keyword = '壁纸'

url = 'https://www.baidu.com/s?wd=' + quote(keyword)

print(url)

Output:

https://www.baidu.com/s?wd=%E5%A3%81%E7%BA%B8unquote()

进行URL解码

分析Robots协议

Robots协议

Robots协议也称作爬虫协议、机器人协议,全名叫作网络爬虫排除标准(Robots Exclusion Protocol),用来告诉爬虫和搜索引擎哪些页面可以抓取,哪些不可以抓取。它通常是一个叫作robot.txt的文本文件,一般放在网站的根目录下。爬虫名称

常见的搜索爬虫的名称及对应的网站:

BaiduSpider 百度 www.baidu.com

Googlebot 谷歌 www.google.com

360Spider 360 搜索 www.so.com

YodaoBot 有道 www.youdao.com

ia_archiver Alexa www.alexa.cn

Scooter altavista www.altavista.comrobotparser

urllib.robotparser模块提供了一个RobotFileParser类,该类的一些方法如下:- set_url():用来设置robots.txt文件的链接。也可在创建RobotFileParser对象时传入链接。

- read():读取robots.txt文件并进行分析。

- parse():用来解析robots.txt文件,传人的参数是robots.txt某些行的内容,它会按照robots.txt的语法规则来分析这些内容。

- can_fetch():该方法传人两个参数,第一个是 User-agent,第二个是要抓取的URL。返回的内容是该搜索引擎是否可以抓取这个URL,结果为True 或False。

- mtime():返回的是上次抓取和分析robots.txt的时间,这对于长时间分析和抓取的搜索爬虫是有必要的,可能需要定期检查来抓取最新的robots.txt。

- modified():同样对长时间分析和抓取的搜索爬虫很有帮助,将当前时间设置为上次抓取和分析robots.txt的时间。

示例:

from urllib.robotparser import RobotFileParser

rp = RobotFileParser()

rp.set_url('http://www.jianshu.com/robots.txt')

rp.read()

#上面两行可以用parse方法来执行读取和分析

#rp.parse(urlopen('http://www.jianshu.com/robots.txt').read().decode('utf-8').split('\n'))

print(rp.can_fetch('*', 'http://www.jianshu.com/p/b67554025d7d'))

print(rp.can_fetch('*', "http://www.jianshu.com/search?q=python&page=1&type=collections"))

Output:

True

False

使用requests

解决urllib中Cookies、登录验证、代理设置不方便的问题。

安装pip install requests

requests的官方文档:http://docs.python-requests.org/

基本用法

requests库包含get()、post()、put()、delete()、head()和options()等方法,分别对应各种方式请求网页。

GET请求

- 基本实例:

import requests

data = {

'name': 'germey',

'age': 22

}

r = requests.get("http://httpbin.org/get", params=data)

print(type(r))

print(r.status)

#网页的返回类型实际是JSON格式的str类型,调用json()可将其转化为字典

print(type(r.json()))

Output:

<class 'requests.models.Response'>

200

<class 'dict'> - 抓取网页

import requests

import re

headers = {

'User-Agent': ('Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) '

'AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/52.0.2743.116 Safari/537.36')

}

r = requests.get("https://www.zhihu.com/explore", headers=headers)

pattern = re.compile('explore-feed.*?question_link.*?>(.*?)</a>', re.S)

titles = re.findall(pattern, r.text)

print(titles) - 抓取二进制数据

import requests

r = requests.get("https://github.com/favicon.ico")

with open('favicon.ico', 'wb') as f:

f.write(r.content)

- 基本实例:

POST请求

import requests

data = {'name': 'germey', 'age': '22'}

r = requests.post("http://httpbin.org/post", data=data)响应

import requests

r = requests.get('http://www.xxyr.cc')

print(type(r.status_code))

print(type(r.headers))

print(type(r.cookies))

print(type(r.url))

print(type(r.history))

print(type(r.text)) #返回内容的字符串形式

print(type(r.content)) #返回内容的二进制形式

print(requests.codes.ok) #内置的返回码

Output:

<class 'int'>

<class 'requests.structures.CaseInsensitiveDict'>

<class 'requests.cookies.RequestsCookieJar'>

<class 'str'>

<class 'list'>

<class 'str'>

<class 'bytes'>

200

高级用法

文件上传

import requests

files = {'file': open('favicon.ico', 'rb')}

r = requests.post('http://httpbin.org/post', files=files)

print(r.text)Cookies

import requests

r = requests.get('https://www.baidu.com')

print(r.cookies)

for key, value in r.cookies.items():

print(key + '=' + value)可将Cookie字段添加到headers里实现登录:

import requests

headers = {

'Cookie': 'q_c1=31653b264a074fc9a57816d1ea93ed8b|1474273938000|1474273938000; d_c0="AGDAs254kAqPTr6NW1U3XTLFzKhMPQ6H_nc=|1474273938"; __utmv=51854390.100-1|2=registration_date=20130902=1^3=entry_date=20130902=1;a_t="2.0AACAfbwdAAAXAAAAso0QWAAAgH28HQAAAGDAs254kAoXAAAAYQJVTQ4FCVgA360us8BAklzLYNEHUd6kmHtRQX5a6hiZxKCynnycerLQ3gIkoJLOCQ==";z_c0=Mi4wQUFDQWZid2RBQUFBWU1DemJuaVFDaGNBQUFCaEFsVk5EZ1VKV0FEZnJTNnp3RUNTWE10ZzBRZFIzcVNZZTFGQmZn|1474887858|64b4d4234a21de774c42c837fe0b672fdb5763b0',

'Host': 'www.zhihu.com',

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.116 Safari/537.36',

}

r = requests.get('https://www.zhihu.com', headers=headers)

print(r.text)或将其作为cookie参数添加到get()方法里:

import requests

cookies = 'q_c1=31653b264a074fc9a57816d1ea93ed8b|1474273938000|1474273938000; d_c0="AGDAs254kAqPTr6NW1U3XTLFzKhMPQ6H_nc=|1474273938"; __utmv=51854390.100-1|2=registration_date=20130902=1^3=entry_date=20130902=1;a_t="2.0AACAfbwdAAAXAAAAso0QWAAAgH28HQAAAGDAs254kAoXAAAAYQJVTQ4FCVgA360us8BAklzLYNEHUd6kmHtRQX5a6hiZxKCynnycerLQ3gIkoJLOCQ==";z_c0=Mi4wQUFDQWZid2RBQUFBWU1DemJuaVFDaGNBQUFCaEFsVk5EZ1VKV0FEZnJTNnp3RUNTWE10ZzBRZFIzcVNZZTFGQmZn|1474887858|64b4d4234a21de774c42c837fe0b672fdb5763b0'

jar = requests.cookies.RequestsCookieJar()

headers = {

'Host': 'www.zhihu.com',

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.116 Safari/537.36'

}

for cookie in cookies.split(';'):

key, value = cookie.split('=', 1)

jar.set(key, value)

r = requests.get('http://www.zhihu.com', cookies=jar, headers=headers)

print(r.text)会话维持

当访问登录网站后的页面,或同一站点的不同页面时,就需要进行会话维持。import requests

s = requests.Session()

s.get('http://httpbin.org/cookies/set/number/123456789')

r = s.get('http://httpbin.org/cookies')

print(r.text)

Output:

{

"cookies": {

"number": "123456789"

}

}SSL证书验证

import requests

response = requests.get('https://www.12306.cn', verify=False) #默认为True,自动验证证书

print(response.status_code)verify=False会忽略证书的验证,但会报一个警告,解决方法如下:- 设置忽略警告

import requests

from requests.packages import urllib3

urllib3.disable_warnings()

response = requests.get('https://www.12306.cn', verify=False)

print(response.status_code) - 捕获警告到日志

import logging

import requests

logging.captureWarnings(True)

response = requests.get('https://www.12306.cn', verify=False)

print(response.status_code) - 指定一个本地证书用作客户端证书

import requests

response = requests.get('https://www.12306.cn', cert=('/path/server.crt', '/path/key'))

print(response.status_code)

- 设置忽略警告

代理设置

import requests

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'http://10.10.1.10:1080',

}

requests.get('https://www.taobao.com', proxies=proxies)若要使用HTTP Basic Auth,可以使用如下代理形式:

import requests

proxies = {

'https': 'http://user:password@10.10.1.10:3128/',

}

requests.get('https://www.taobao.com', proxies=proxies)requests还支持SOCKS代理:

安装:pip3 install 'requests[socks]'import requests

proxies = {

'http': 'socks5://user:password@host:port',

'https': 'socks5://user:password@host:port'

}

requests.get('https://www.taobao.com', proxies=proxies)超时设置

为了防止服务器不能及时响应,应该设置一个超时时间,即超过了这个时间还没有得到响应就报错。import requests

r = requests.get('https://www.taobao.com', timeout=1)

print(r.status_code)timeout=1表示超时时间为1秒,默认为None,即永远等待。

实际上,请求分为两个阶段,即连接(connect)和读取(read)。上面设置的timeout将用作连接和读取这二者的timeout总和。

如果要分别指定,就可以传入一个元组:r = requests.get('https://www.taobao.com', timeout=(5,11, 30))身份认证

import requests

#auth=('username', 'password')即auth=HTTPBasicAuth('username', 'password')

r = requests.get('http://localhost:5000', auth=('username', 'password'))

print(r.status_code)此外requests还提供了其他认证方式,如OAuth认证等。

Prepared Request

用于将请求表示为数据结构,其中各个参数通过一个Request对象来表示。from requests import Request, Session

url = 'http://httpbin.org/post'

data = {

'name': 'germey'

}

headers = {

'User-Agent': ('Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 ')

('(KHTML, like Gecko) Chrome/53.0.2785.116 Safari/537.36')

}

s = Session()

req = Request('POST', url, data=data, headers=headers)

#Session的prepare_request()方法将其转化为一个Prepared Request对象

prepped = s.prepare_request(req)

r = s.send(prepped)

print(r.text)

正则表达式

详见: 正则表达式复习

抓取猫眼电影排行

详见https://github.com/Python3WebSpider/MaoYan

Ch 3 解析库的使用

使用XPath

lxml库安装:pip install lxml

如果想查询更多XPath的用法,可以查看:http://www.w3school.eom.cn/xpath/index.asp

如果想查询更多lxml库的用法,可以查看:http://lxml.de/

XPath概览

- XPath,全称XML Path Language,即XML路径语言,是一门在XML文档中查找信息的语言,最初是用来搜寻XML文档的,但同样适用于HTML文档的搜索。

- XPath于1999年ll月16日成为W3C标准,它被设计为供XSLT、XPointer以及其他XML解析软件使用,更多的文档可以访问其官方网站:https://www.w3.org/TR/xpath。

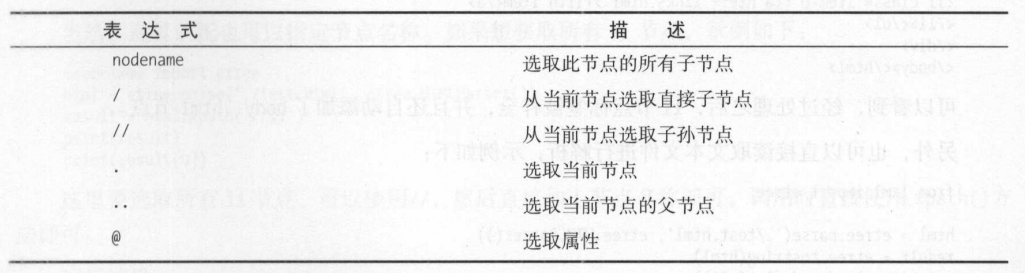

Xpath常用规则

实例引入

from lxml import etree |

节点选择

- 所有节点

from lxml import etree

html = etree.parse('./test.html', etree.HTMLParser())

result = html.xpath('//*') #选择所有节点

#result = html.xpath('//li') #选择所有li节点

print(result)

print(result[0])

#返回形式是一个列表,每个元素是Element类型

Output:

[<Element li at 0x2257c34aa48>, <Element li at 0x2257c34aa88>]

<Element li at 0x2257c34aa48> - 子节点

/是直接节点,//是所有节点。

如选择li节点的所有直接a子节点,可以用//li/a,

选择ul节点下的所有a子节点,可以用//ul//a - 父节点

首先选中href属性为link4.html的a节点,然后再获取其父节点,然后再获取其class属性。from lxml import etree

html = etree.parse('./test.html', etree.HTMLParser())

result = html.xpath('//a[@href="link4.html"]/../@class')

#或者

result = html.xpath('//a[@href="link4.html"]/parent::*/@class') - 按序选择具体参考:http://www.w3school.com.cn/xpath/xpath_functions.asp

from lxml import etree

html = etree.parse('./test.html', etree.HTMLParser())

result = html.xpath('//li[1]/a/text()') #序号从1开始

result = html.xpath('//li[last()]/a/text()') #选取最后一个

result = html.xpath('//li[position()<3]/a/text()')#选取第1、2个

result = html.xpath('//li[last()-2]/a/text()') #选取倒数第三个 - 节点轴选择

from lxml import etree

html = etree.parse('./test.html', etree.HTMLParser())

result = html.xpath('//li[1]/ancestor::*') #选取第一个li节点的所有祖先节点

result = html.xpath('//li[1]/ancestor::div') #选取第一个li节点的祖先div节点

result = html.xpath('//li[1]/attribute::*') #获取第一个li节点的所有属性值

result = html.xpath('//li[1]/child::a') #child::直接子节点

result = html.xpath('//li[1]/descendant::span') #descendant::子孙节点

result = html.xpath('//li[1]/following::*[2]') #following::当前结点之后的所有节点

result = html.xpath('//li[1]/following-sibling::*') #following-sibling::

#当前结点之后的所有同级节点

文本获取

from lxml import etree |

属性操作

- 属性获取

获取所有li节点下所有a节点的href属性:from lxml import etree

html = etree.parse('./test.html', etree.HTMLParser())

result = html.xpath('//li/a/@href') - 属性匹配

通过属性筛选节点:from lxml import etree

html = etree.parse('./test.html', etree.HTMLParser())

result = html.xpath('//li/a[@href="link1.html"]') - 属性多值匹配

用contains()函数:from lxml import etree

text = '''

<li class="li li-first"><a href="link.html">first item</a></li>

'''

html = etree.HTML(text)

result = html.xpath('//li[contains(@class, "li")]/a/text()') - 多属性匹配

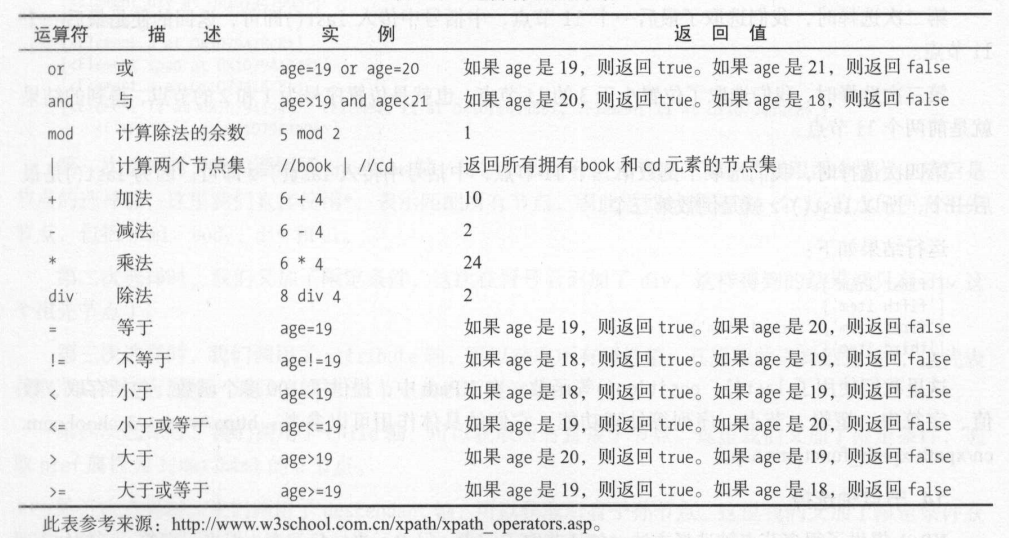

用运算符and来连接:XPath中的运算符:from lxml import etree

text = '''

<li class="li li-first" name="item"><a href="link.html">first item</a></li>

'''

html = etree.HTML(text)

result = html.xpath('//li[contains(@class, "li") and @name="item"]/a/text()')

使用Beautiful Soup

安装:pip install beautifulsoup4

简介

Beautiful Soup是Python的一个HTML或XML的解析库,可以用它来方便地从网页中提取数据.

官方解释如下:

- Beautiful Soup提供一些简单的、Python式的函数来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。

- Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为UTF-8编码。不需要考虑编码方式,除非文档没有指定一个编码方式,这时仅需说明一下原始编码方式就可以了。

- Beautiful Soup已成为和lxml、html6lib 一样出色的Python解释器,为用户灵活地提供不同的解析策略或强劲的速度。

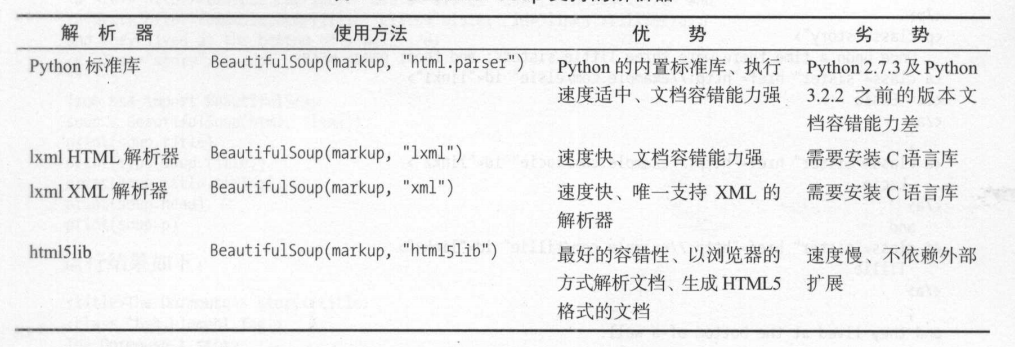

解析器

Beautiful Soup在解析时实际上依赖解析器,它除了支持Python标准库中的HTML解析器外,还支持一些第三方解析器。(推荐lxml)

基本用法

from bs4 import BeautifulSoup |

节点选择器

- 选择元素

from bs4 import BeautifulSoup

html = ''

soup = BeautifulSoup(html, 'lxml')

print(soup.title)

print(type(soup.title))

print(soup.title.string)

print(soup.head)

print(soup.p) #选择第一个匹配的p节点

Output:

<title>The Dormouse's story</title>

<class 'bs4.element.Tag'>

The Dormouse's story

<head><title>The Dormouse's story</title></head>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p> - 提取信息

- 获取名称

print(soup.title.name)

title - 获取属性或:

print(soup.p.attrs)

print(soup.p.attrs['name'])

{'class': ['title'], 'name': 'dromouse'}

dromouseprint(soup.p['class'])

print(soup.p['name'])

['title'] #class属性值可能有多个,所以返回列表

dromouse - 获取内容

print(soup.title.string) #选择第一个匹配的

The Dormouse's story

- 获取名称

- 嵌套选择

print(soup.head.title.string) #选择head内的title节点

The Dormouse's story - 关联选择

- 子节点和子孙节点

直接子节点:或soup.p.contents #返回包含各直接子节点的列表

子孙节点:for i, child in enumerate(soup.p.children): #返回生成器类型

print(i, child)for i, child in enumerate(soup.p.descendants):

print(i, child) - 父节点和祖先节点

直接父节点:祖先节点:print(soup.a.parent)

for i, parent in enumerate(soup.p.parents):

print(i, parent) - 兄弟节点

print('Next Sibling', soup.a.next_sibling)

print('Prev Sibling', soup.a.previous_sibling)

print('Next Siblings', list(enumerate(soup.a.next_siblings)))

print('Prev Siblings', list(enumerate(soup.a.previous_siblings))) - 提取信息

print(soup.a.next_sibling.string)

print(list(soup.a.parents)[0].attrs['class'])

- 子节点和子孙节点

方法选择器

- findall()

API:示例:find_all(name, attrs, recursive, text, **kwargs)

from bs4 import BeautifulSoup

html = ''

soup = BeautifulSoup(html, 'lxml')

print(soup.find_all(name='ul'))

print(type(soup.find_all(name='ul')[0]))

#返回结果为列表类型,每个元素为bs4.element.Tag类型

print(soup.find_all(attrs={'id': 'list-1'}))

print(soup.find_all(attrs={'name': 'elements'}))

或

print(soup.find_all(id='list-1'))

print(soup.find_all(class_='element')) #class_因为是关键字

print(soup.find_all(text=re.compile('link')))

#参数可以是字符串,也可以是正则表达式对象 - find()

返回第一个匹配的元素。 - find_parents()和find_parent():前者返回所有祖先节点,后者返回直接父节点。

- find_next_siblings()和find_next_sibling():前者返回后面所有的兄弟节点,后者返回后面第一个兄弟节点。

- find_previous_siblings()和find_previous_sibling():前者返回前面所有的兄弟节点,后者返回前面第一个兄弟节点 。

- find_all_next()和find_next():前者返回节点后所有符合条件的节点,后者返回第一个符合条件的节点。

- find_all_previous()和find_previous():前者返回节点前所有符合条件的节点,后者返回第一个符合条件的节点。

CSS选择器

参考:http://www.w3school.com.cn/cssref/css_selectors.asp

from bs4 import BeautifulSoup |

使用pyquery

安装pip install pyquery

pyquery的官方文档:http://pyquery.readthedocs.io

初始化

import requests |

基本CSS选择器

关于CSS选择器的更多用法,可以参考:https://www.w3school.com.cn/css/css_selector_type.asp

from pyquery import PyQuery |

查找结点

下面介绍一些常用的查询函数,这些函数和jQuery中函数的用法完全相同。

from pyquery import PyQuery |

遍历

from pyquery import PyQuery |

获取信息

- 获取属性

提取到某个PyQuery类型的节点后,就可以调用attr()方法来获取属性:from pyquery import PyQuery

html = ''

doc = PyQuery(html)

a = doc('.item-0.active a')

print(a)

print(type(a))

print(a.attr('href')) #若a有多个,只返回第一个a的属性值

print(a.attr.href)

<a href="link3.html"><span class="bold">third item</span></a>

<class 'pyquery.pyquery.PyQuery'>

link3.html

link3.html - 获取文本

from pyquery import PyQuery

html = ''

doc = PyQuery(html)

li = doc('li')

print(li.html()) #返回第一个节点的内部HTML文本

print(type(li.html()))

print(li.text()) #返回所有节点内部的纯文本,中间用一个空格分隔开

print(type(li.text()))

<a href="link2.html">second item</a>

<class 'str'>

second item third item fourth item fifth item

<class 'str'>

节点操作

pyquery提供了一系列方法来对节点进行动态修改,比如为某个节点添加一个 class,移除某个节点等,如append()、empty()和prepend()等方法,它们和jQuery的用法完全一致,详细的用法可以参考官方文档:http://pyquery.readthedocs.io/en/latest/api.html

- addClass和removeClass

from pyquery import PyQuery

html = ''

doc = PyQuery(html)

li = doc('.item-0.active')

li.removeClass('active')

li.addClass('active') - attr、text和html

li.attr('name', 'link') #修改或增加name属性值为link

li.text('changed item') #将li节点内部的文本替换为纯文本

li.html('<span>changed item</span>')#将li节点内部的文本替换为HTML文本 - remove()

wrap = doc('.wrap')

wrap.find('p').remove()

type(wrap.find('p'))

<class 'pyquery.pyquery.PyQuery'>

伪类选择器

css选择器之所以强大,还有一个很重要的原因,就是支持多种多样的伪类选择器,例如选择第一个节点、最后一个节点、奇偶数节点、包含某一文本的节点等。示例如下:

from pyquery import PyQuery |

Ch 4 数据存储

文件存储

TXT文本存储

with open('test.txt', 'a', encoding='utf-8') as file: |

打开方式:

- r:以只读方式打开文件。文件的指针将会放在文件的开头。这是默认模式。

- rb:以二进制只读方式打开一个文件。文件指针将会放在文件的开头。

- r+:以读写方式打开一个文件。文件指针将会放在文件的开头。

- rb+:以二进制读写方式打开一个文件。文件指针将会放在文件的开头。

- w:以写入方式打开一个文件。如果该文件已存在,则将其瞿盖。如果该文件不存在,则创建新文件。

- wb:以二进制写入方式打开一个文件。如果该文件已存在,则将其覆盖。如果该文件不存在,则创建新文件。

- w+:以读写方式打开一个文件。如果该文件已存在,则将其覆盖。如果该文件不存在,则创建新文件。

- wb+:以二进制读写格式打开一个文件。如果该文件已存在,则将其覆盖。如果该文件不存在,则创建新文件。

- a:以追加方式打开一个文件。如果该文件已存在,文件指针将会放在文件结尾。也就是说,新的内容将会被写入到已有内容之后。如果该文件不存在,则创建新文件来写入。

- ab:以二进制追加方式打开一个文件。如果该文件已存在,则文件指针将会放在文件结尾。如果该文件不存在,则创建新文件来写入。

- a+:以读写方式打开一个文件。如果该文件已存在,文件指针将会放在文件的结尾。文件打开时会是追加模式。如果眩文件不存在,则创建新文件来读写。

- ab+:以二进制追加方式打开一个文件。如果该文件已存在,则文件指针将会放在文件结尾。如果该文件不存在,则创建新文件用于读写。

JSON文件存储

JSON,全称为JavaScript Object Notation,也就是JavaScript对象标记,通过对象和数组的组合来表示数据,构造简洁但是结构化程度非常高,是一种轻量级的数据交换格式。

对象和数组:

- 对象:在JavaScript中使用花括号{}包裹起来的内容,数据结构为{ keyl : valuel, key2 : value2, … }的键值对结构。 在面向对象的语言中,key为对象的属性,value为对应的值。键名可以使用整数和字符串来表示。值的类型可以是任意类型。

- 数组:数组在JavaScript中是方括号[]包裹起来的内容,数据结构为[ “java”, “javascript”]的索引结构。在JavaScript中,数组是一种比较特殊的数据类型,它也可以像对象那样使用键值对,但还是索引用得多。同样,值的类型可以是任意类型。

示例:loads()和dumps()

import json |

若json文件包含多条记录,可以:

#逐行读取 |

参见:

json.decoder.JSONDecodeError: Extra data: line 2 column 1 (char 190) [duplicate]

Python json.loads shows ValueError: Extra data

CSV文件存储

CSV,全称为Comma-Separated Values,中文可以叫作逗号分隔值或字符分隔值,其文件以纯文本形式存储表格数据。

- 写入

import csv

with open ('data.csv', 'w', encoding='utf-8') as csvfile:

#delimiter指定分隔符 lineterminator指定行终止符,默认\n

writer = csv.writer(csvfile, delimiter=' ', lineterminator='\n\n')

writer.writerow(['id', 'name', 'age'])

writer.writerow(['10001', 'Mike', 20])

writer.writerow(['10002', 'Bob', 22])

#写入多行

writer.writerows(['10001', 'Mike', 20], ['10002', 'Bob', 22])

#字典写入

fieldnames = ['id', 'name', 'age')

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

writer. writeheader()

writer.writerow({'id': '10001', 'name' :'Mike', 'age' : 20})

writer.writerow({'id': '10002', 'name' : 'Bob', 'age' : 22})

writer.writerow({'id': '10003', 'name' :'Jordan', 'age' : 21}) - 读取

import csv

with open('data.csv','r', encoding='utf 8') as csvfile:

reader = csv.reader(csvfile)

# fileData = list(reader) #fileData[0][0]

for row in reader:

print('row'+str(row.line_num)+str(row))

#或

import pandas as pd

df = pd.read csv('data.csv')

print(df)

关系型数据库存储

关系型数据库是基于关系模型的数据库,而关系模型是通过二维表来保存的,所以它的存储方式就是行列组成的表,每一列是一个字段,每一行是一条记录。

表可以看作某个实体的集合,而实体之间存在联系,这就需要表与表之间的关联关系来体现,如主键外键的关联关系。多个表组成一个数据库,也就是关系型数据库。

MySQL存储

相关链接:

- GitHub: https://github.com/PyMySQL/PyMySQL

- 官方文档:http://pymysql.readthedocs.io/

- PyPI: https://pypi.python.org/pypi/PyMySQL

安装:pip install pymysql

相关操作:

- 连接、创建数据库

import pymysql

db = pymysql.connect(host='localhost',user='root', password='123456', port=3306)

cursor = db.cursor() #获得操作游标

cursor.execute('SELECT VERSION()')

data = cursor.fetchone() #获得第一条数据

print('Database version:', data)

cursor.execute("CREATE DATABASE spiders DEFAULT CHARACTER SET utf8")

db.close()

Output:

Database version: ('5.7.29-log',) - 创建表

import pymysql

db = pymysql.connect(host='localhost', user='root', password='123456', port=3306, db='spiders')

cursor = db.cursor()

sql = 'CREATE TABLE IF NOT EXISTS students (id VARCHAR(255) NOT NULL, name VARCHAR(255) NOT NULL, age INT NOT NULL, PRIMARY KEY (id))'

cursor.execute(sql)

db.close() - 插入数据改进,根据字典动态构造:

import pymysql

id = '20120001'

user = 'Bob'

age = 20

db = pymysql.connect(host='localhost', user='root', password='123456', port=3306, db='spiders')

cursor = db.cursor()

sql = 'INSERT INTO students(id, name, age) values(%s, %s, %s)' #采用格式化符%而非字符串拼接

try:

cursor.execute(sql, (id, user, age))

db.commit()

except:

db.rollback()

db.close()这里涉及事务的问题,事务的特性如下:import pymysql

data = {

'id': '20120001',

'name': 'Bob',

'age': 20

}

table = 'students'

keys = ', '.join(data.keys())

values = ', '.join(['%s'] * len(data))

sql = 'INSERT INTO {table}({keys}) VALUES ({values})'.format(table=table, keys=keys, values=values)

#INSERT INTO students(id , name, age) VALUES (%s, %s, %s)

db = pymysql.connect(host='localhost', user='root', password='123456', port=3306, db='spiders')

cursor = db.cursor()

try:

if cursor.execute(sql, tuple(data.values())):

print('Successful')

db.commit()

except:

print('Failed')

db.rollback()

db.close()- 原子性(atomicity):事务是一个不可分割的工作单位,事务中包括的诸操作要么都做,要么都不做。

- 一致性(consistency):事务必须使数据库从一个一致性状态变到另一个一致性状态。一致性与原子性是密切相关的。

- 隔离性(isolation):一个事务的执行不能被其他事务干扰,即一个事务内部的操作及使用的数据对并发的其他事务是隔离的,并发执行的各个事务之间不能互相干扰。

- 持久性(durability):持续性也称永久性(permanence),指一个事务一旦提交,它对数据库中数据的改变就应该是永久性的。接下来的其他操作或故障不应该对其有任何影响。

- 更新数据改进,字典传值+去重:

sql = 'UPDATE students SET age = %s WHERE name = %s'

try:

cursor.execute(sql, (25, 'Bob'))

db.commit()

except:

db.rollback()import pymysql

data = {

'id': '20120001',

'name': 'Bob',

'age': 21

}

table = 'students'

keys = ', '.join(data.keys())

values = ', '.join(['%s'] * len(data))

db = pymysql.connect(host='localhost', user='root', password='123456', port=3306, db='spiders')

cursor = db.cursor()

sql = 'INSERT INTO {table}({keys}) VALUES ({values}) ON DUPLICATE KEY UPDATE'.format(table=table, keys=keys,

values=values)

#INSERT INTO students(id, name, age) VALUES (%s, %s, %s) ON DUPLICATE KEY UPDATE

update = ','.join([" {key} = %s".format(key=key) for key in data])

sql += update

#INSERT INTO students(id, name, age) VALUES (%s, %s, %s) ON DUPLICATE KEY UPDATE id = %s, name = %s, age = %s

try:

if cursor.execute(sql, tuple(data.values()) * 2):

print('Successful')

db.commit()

except:

print('Failed')

db.rollback()

db.close() - 删除数据

import pymysql

table = 'students'

condition = 'age > 20'

db = pymysql.connect(host='localhost', user='root', password='123456', port=3306, db='spiders')

cursor = db.cursor()

sql = 'DELETE FROM {table} WHERE {condition}'.format(table=table, condition=condition)

try:

cursor.execute(sql)

db.commit()

except:

db.rollback()

db.close() - 查询数据

逐行读取(注意游标类似全局变量)import pymysql

sql = 'SELECT * FROM students WHERE age >= 20'

db = pymysql.connect(host='localhost', user='root', password='123456', port=3306, db='spiders')

cursor = db.cursor()

try:

cursor.execute(sql)

print('Count:', cursor.rowcount)

row = cursor.fetchone()

# results = cursor.fetchall()

while row:

print('Row:', row)

row = cursor.fetchone()

except:

print('Error')

非关系型数据库存储

NoSQL,全称Not Only SQL,意为不仅仅是SQL,泛指非关系型数据库。NoSQL是基于键值对的,且不需要经过SQL层的解析,数据之间没有耦合性,性能非常高。

非关系型数据库又可细分如下。

- 键值存储数据库:代表有Redis、Voldemort和Oracle BDB等。

- 列存储数据库:代表有Cassandra、HBase和Riak等。

- 文档型数据库:代表有CouchDB和MongoDB等。

- 图形数据库:代表有Neo4J、lnfoGrid和Infinite Graph等。

对于爬虫的数据存储来说一条数据可能存在某些字段提取失败而缺失的情况,而且数据可能随时调整。另外,数据之间还存在嵌套关系。如果使用关系型数据库存储,一是需要提前建表,二是如果存在数据嵌套关系的话,需要进行序列化操作才可以存储,非常不方便。如果用了非关系型数据库,就可以避免一些麻烦,更简单高效。

MongoDB存储

MongoDB 是由C++语言编写的非关系型数据库,是一个基于分布式文件存储的开源数据库系统,其内容存储形式类似JSON对象,字段值可以包含其他文档、数组及文档数组,非常灵活。

相关链接:

- GitHub: https://github.com/mongodb/mongo-python-driver

- 官方文档:https://api.mongodb.com/python/current/

- PyPI: https://pypi.python.org/pypi/pymongo

安装:pip install pymongo

相关操作: - 初始化

import pymongo

from pymongo import MongoClient

#连接MongoDB

client = pymongo.MongoClient(host='localhost', port=27017)

# client = MongoClient('mongodb://localhost:27017/')

#指定数据库

db = client.test

# db = client['test']

#指定集合

collection = db.students

# collection = db['students'] - 插入数据

student1 = {

'id': '20170101',

'name': 'Jordan',

'age': 20,

'gender': 'male'

}

student2 = {

'id': '20170202',

'name': 'Mike',

'age': 21,

'gender': 'male'

}

#insert返回一个ObjectId类型的_id值

result = collection.insert(student1)

result = collection.insert([student1, student2])

#官方推荐使用更加严格的方法

#返回的是InsertOneResult对象

result = collection.insert_one(student1)

print(result.inserted_id)

#返回的是InsertManyResult对象

result = collection.insert_many([student1, student2])

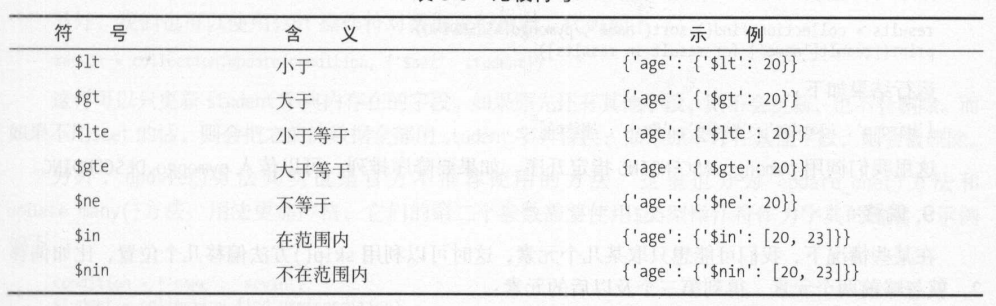

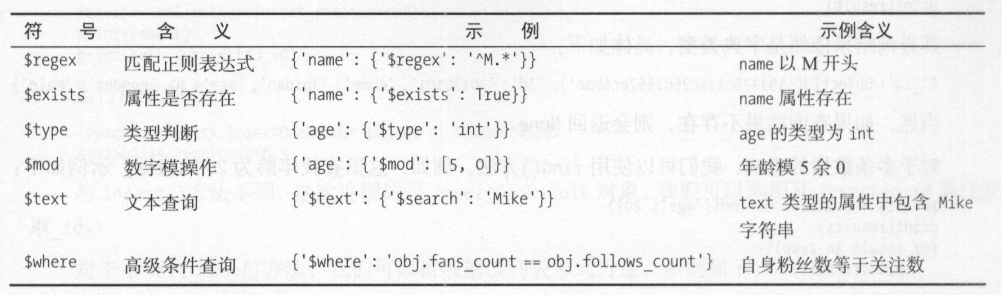

print(result.inserted_ids) - 查询比较符号表如下:

查询单条数据

result = collection.find_one({'name': 'Mike'})

# 根据ObjectId查询

from bson.objectid import ObjectId

result = collection.find_one({'_id': ObjectId('593278c115c2602667ec6bae')})

# 多条数据查询

results = collection.find({'age': 20}) #返回Cursor类型,相当于生成器

for result in results:

print(result)

# 条件查询

results = collection.find({'age': {'$gt': 20}})

# 正则匹配查询

results = collection.find({'age': {'$Regex': '^M.*'}})

功能符号表如下:

- 计数

count = collection.find('age': 20}).count()

- 排序

results = collection.find().sort('name', pymongo.ASCENDING)

- 偏移

# 偏移2,忽略前两个元素,得到第三个及以后的元素

results = collection.find().sort('name', pymongo.ASCENDING).skip(2)

# 指定个数

results = collection.find().sort('name', pymongo.ASCENDING).skip(2).limit(2)

#数据量大时采用以下办法

collection.find({'_id': {'$gt': ObjectId('593278c815c2602678bb2b8d')}}) - 更新

condition = {'name': 'Kevin'}

student = collection.find_one(condition)

student['age'] = 25

# 返回结果是字典形式,ok代表执行成功,nModified代表影响的数据条数

result = collection.update(condition, student)

# 只更新该字段,不影响其他已存在字段

result = collection.update_one(condition, {'$set': student})

print(result.matched_count, result.modified_count) - 删除

result = collection.remove({'name': 'Kevin'})

result = collection.delete_one({'name': 'Kevin'})

result = collection.delete_many({'age': {'$lt': 25}})

print(result.deleted_count) - 其他操作

- 另外,PyMongo还提供了一些组合方法,如find_one_and_delete()、find one and_replace()和find_one_and_update(),它们是查找后删除、替换和更新操作,其用法与上述方法基本一致。

- 还可以对索引进行操作,相关方法有create_index()、create_indexes()和drop_index()等。

- 关于PyMongo的详细用法,可以参见官方文档:

http://api.mongodb.com/python/current/api/pymongo/collection.html - 另外,还有对数据库和集合本身等的一些操作,可以参见官方文档:

http://api.mongodb.com/python/current/api/pymongo

Redis存储

GitHub: https://github.com/andymccurdy/redis-py

官方文档:https://redis-py.readthedocs.io/

- 初始化或

from redis import StrictRedis

redis = StrictRedis(host='localhost', port=6379, db=0, password='foobared')

redis.set('name', 'Bob')

print(redis.get('name'))from redis import StrictRedis, ConnectionPool

pool = ConnectionPool(host='localhost', port=6379, db=0, password='foobared')

redis = StrictRedis(connection_pool=pool)

# 通过URL构建pool

url = 'redis://:foobared@localhost:6379/0'

pool = ConnectionPool.from_url(url)

redis = StrictRedis(connection_pool=pool) - 键操作

- 字符串操作

- 列表操作

- 散列操作

- 集合操作

- 有序集合操作

- RedisDump

- redis-dump

- redis-load

Ch 5 Ajax数据爬取

什么是Ajax

Ajax分析方法

Ajax结果提取

分析Ajax爬取今日头条节拍美图

Ch 6 动态渲染页面爬取

Selenium的使用

基本使用

from selenium import webdriver |

浏览器首先会跳转到百度,然后在搜索框中输入 Python,接着跳转到搜索结果页。

声明浏览器对象

Selenium 支持非常多的浏览器,如 Chrome、Firefox、Edge 等,还有 Android、BlackBerry 等手机端的浏览器。另外,也支持无界面浏览器 PhantomJS。用如下方式初始化:

from selenium import webdriver |

访问页面

可以用 get() 方法来请求网页,参数传入链接 URL 即可。比如,这里用 get() 方法访问淘宝,然后打印出源代码,代码如下:

from selenium import webdriver |

查找节点

- 单个节点

比如,find_element_by_name()是根据 name 值获取,find_element_by_id()是根据 id 获取。另外,还有根据 XPath、CSS 选择器等获取的方式。

代码实现:这里列出所有获取单个节点的方法:from selenium import webdriver

browser = webdriver.Chrome()

browser.get('https://www.taobao.com')

input_first = browser.find_element_by_id('q')

input_second = browser.find_element_by_css_selector('#q')

input_third = browser.find_element_by_xpath('//*[@id="q"]')

print(input_first, input_second, input_third)

browser.close()另外,Selenium 还提供了通用方法find_element_by_id

find_element_by_name

find_element_by_xpath

find_element_by_link_text

find_element_by_partial_link_text

find_element_by_tag_name

find_element_by_class_name

find_element_by_css_selectorfind_element(),它需要传入两个参数:查找方式 By 和值。实际上,它就是find_element_by_id()这种方法的通用函数版本,比如find_element_by_id(id)就等价于find_element(By.ID, id),二者得到的结果完全一致。示例:input_first = browser.find_element(By.ID, 'q')

- 多个节点

使用find_elements(),示例:得到的内容变成了列表类型,列表中的每个节点都是from selenium import webdriver

browser = webdriver.Chrome()

browser.get('https://www.taobao.com')

lis = browser.find_elements_by_css_selector('.service-bd li')

print(lis)

browser.close()WebElement类型。

这里列出所有获取多个节点的方法:也可以直接用 find_elements() 方法来选择,这时可以这样写:find_elements_by_id

find_elements_by_name

find_elements_by_xpath

find_elements_by_link_text

find_elements_by_partial_link_text

find_elements_by_tag_name

find_elements_by_class_name

find_elements_by_css_selectorlis = browser.find_elements(By.CSS_SELECTOR, '.service-bd li')

节点交互

Selenium 可以驱动浏览器来执行一些操作,也就是说可以让浏览器模拟执行一些动作。比较常见的用法有:输入文字时用 send_keys() 方法,清空文字时用 clear() 方法,点击按钮时用 click() 方法。示例如下:

from selenium import webdriver |

更多的操作可以参见官方文档的交互动作介绍:http://selenium-python.readthedocs.io/api.html#module-selenium.webdriver.remote.webelement。

动作链

另外一些操作,没有特定的执行对象,比如鼠标拖曳、键盘按键等,这些动作用另一种方式来执行,那就是动作链。

比如,现在实现一个节点的拖曳操作,将某个节点从一处拖曳到另外一处,可以这样实现:

from selenium import webdriver |

更多的动作链操作参考官方文档:http://selenium-python.readthedocs.io/api.html#module-selenium.webdriver.common.action_chains。

执行 JavaScript

对于某些操作,Selenium API 并没有提供。比如,下拉进度条,它可以直接模拟运行 JavaScript,此时使用 execute_script() 方法即可实现,代码如下:

from selenium import webdriver |

获取节点信息

- 获取属性

使用 get_attribute() 方法来获取节点的属性,示例如下:from selenium import webdriver

browser = webdriver.Chrome()

url = 'https://www.zhihu.com/explore'

browser.get(url)

logo = browser.find_element_by_id('zh-top-link-logo')

print(logo)

print(logo.get_attribute('class')) - 获取文本值

每个 WebElement 节点都有 text 属性,直接调用这个属性就可以得到节点内部的文本信息,这相当于 Beautiful Soup 的get_text()方法、pyquery 的text()方法,示例如下:from selenium import webdriver

browser = webdriver.Chrome()

url = 'https://www.zhihu.com/explore'

browser.get(url)

input = browser.find_element_by_class_name('zu-top-add-question')

print(input.text) - 获取 id、位置、标签名和大小

示例如下:from selenium import webdriver

browser = webdriver.Chrome()

url = 'https://www.zhihu.com/explore'

browser.get(url)

input = browser.find_element_by_class_name('zu-top-add-question')

print(input.id)

print(input.location)

print(input.tag_name)

print(input.size)切换 Frame

网页中有一种节点叫作 iframe,也就是子 Frame,相当于页面的子页面,它的结构和外部网页的结构完全一致。Selenium 打开页面后,它默认是在父级 Frame 里面操作,而此时如果页面中还有子 Frame,它是不能获取到子 Frame 里面的节点的。这时就需要使用 switch_to.frame() 方法来切换 Frame。示例如下:import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

browser = webdriver.Chrome()

url = 'http://www.runoob.com/try/try.php?filename=jqueryui-api-droppable'

browser.get(url)

browser.switch_to.frame('iframeResult')

try:

logo = browser.find_element_by_class_name('logo')

except NoSuchElementException:

print('NO LOGO')

browser.switch_to.parent_frame()

logo = browser.find_element_by_class_name('logo')

print(logo)

print(logo.text)

延时等待

隐式等待

当使用隐式等待执行测试的时候,如果 Selenium 没有在 DOM 中找到节点,将继续等待,超出设定时间后,则抛出找不到节点的异常。换句话说,当查找节点而节点并没有立即出现的时候,隐式等待将等待一段时间再查找 DOM,默认的时间是 0。示例如下:from selenium import webdriver

browser = webdriver.Chrome()

browser.implicitly_wait(10)

browser.get('https://www.zhihu.com/explore')

input = browser.find_element_by_class_name('zu-top-add-question')

print(input)显式等待

指定要查找的节点,然后指定一个最长等待时间。如果在规定时间内加载出来了这个节点,就返回查找的节点;如果到了规定时间依然没有加载出该节点,则抛出超时异常。示例如下:from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

browser = webdriver.Chrome()

browser.get('https://www.taobao.com/')

wait = WebDriverWait(browser, 10)

input = wait.until(EC.presence_of_element_located((By.ID, 'q')))

button = wait.until(EC.element_to_be_clickable((By.CSS_SELECTOR, '.btn-search')))

print(input, button)这里首先引入 WebDriverWait 这个对象,指定最长等待时间,然后调用它的 until() 方法,传入要等待条件 expected_conditions。比如,这里传入了 presence_of_element_located 这个条件,代表节点出现的意思,其参数是节点的定位元组,也就是 ID 为 q 的节点搜索框。

这样可以做到的效果就是,在 10 秒内如果 ID 为 q 的节点(即搜索框)成功加载出来,就返回该节点;如果超过 10 秒还没有加载出来,就抛出异常。

对于按钮,可以更改一下等待条件,比如改为 element_to_be_clickable,也就是可点击,所以查找按钮时查找 CSS 选择器为.btn-search 的按钮,如果 10 秒内它是可点击的,也就是成功加载出来了,就返回这个按钮节点;如果超过 10 秒还不可点击,也就是没有加载出来,就抛出异常。

等待条件还有很多,比如判断标题内容,判断某个节点内是否出现了某文字等。如下所示:

更多等待条件的参数及用法,参考官方文档:http://selenium-python.readthedocs.io/api.html#module-selenium.webdriver.support.expected_conditions。

前进和后退

示例如下:

import time |

Cookies

获取、添加、删除 Cookies 等。示例如下:

from selenium import webdriver |

选项卡管理

示例如下:

import time |

异常处理

节点未找到的异常,示例如下:

from selenium import webdriver |

更多的异常类,可以参考官方文档:http://selenium-python.readthedocs.io/api.html#module-selenium.common.exceptions。

Chrome Headless 模式

从 Chrome 59 版本开始,已经开始支持 Headless 模式,也就是无界面模式,这样爬取的时候就不会弹出浏览器了。如果要使用此模式,请把 Chrome 升级到 59 版本及以上。启用 Headless 模式的方式如下:

chrome_options = webdriver.ChromeOptions() |

Splash的使用

Splash是一个JavaScript渲染服务,是一个带有HTTP API的轻量级浏览器,同时对接了Python中的Twisted和QT库。

安装运行:

docker run -p 8050:8050 scrapinghub/splash |

以守护态运行:

docker run -d -p 8050:8050 scrapinghub/splash |

Splash 使用未绑定的内存缓冲,因此它最终会占用所有的内存。一个解决的办法是在它占用过量内存时进行重启。 Splash中的 –maxrss 参数正是这个作用。您还可以在Docker中添加 –memory 选项。

在正式产品中固定使用同一个版本的Splash会是一个好的做法。相比于使用 scrapinghub/splash 来说 使用像 scrapinghub/splash:2.0 这样的可能会更好

如果您希望设置Splash使用的最大内存为4GB,并且加上守护进程,崩溃重启这些特性,您可以使用下面的命令

docker run -d -p 8050:8050 --memory=4.5G --restart=always scrapinghub/splash:3.5 --maxrss 4000 |

当然,您可能需要一个负载均衡。这样您可以在Splash中进行与Aquarium或者HAProxy 相关的配置

功能介绍

- 利用Splash,可以实现如下功能:

- 异步方式处理多个网页渲染过程;

- 获取渲染后的页面的源代码或截图;

- 通过关闭图片渲染或者使用Adblock规则来加快页面渲染速度;

- 可执行特定的JavaScript脚本;

- 可通过Lua脚本来控制页面渲染过程;

- 获取渲染的详细过程并通过HAR(HTTP Archive)格式呈现。

Splash Lua脚本

Splash可以通过Lua脚本执行一系列渲染操作,这样我们就可以用Splash来模拟类似Chrome、PhantomJS的操作了。

入口及返回值

实例:function main(splash, args)

splash:go("http://www.baidu.com")

splash:wait(0.5)

local title = splash:evaljs("document.title")

return {title=title}

end

Output:

Splash Response: Object

title: "百度一下,你就知道"通过evaljs()方法传人JavaScript脚本,而document.title的执行结果就是返回网页标题,执行完毕后将其赋值给一个title变盘,随后将其返回。

main()方法名称必须是固定的,Splash会默认调用这个方法。该方法的返回值既可以是字典形式,也可以是字符串形式,最后都会转化为Splash HTTP Response。异步处理

实例:function main(splash, args)

local example_urls = {"www.baidu.com", "www.taobao.com", "www.zhihu.com"}

local urls = args.urls or example_urls

local results = {}

for index, url in ipairs(urls) do

local ok, reason = splash:go("http://" .. url)

if ok then

splash:wait(2)

results[url] = splash:png()

end

end

return results

end运行结果是三个站点的截图。

在脚本内调用的wait()方法类似于Python中的sleep(),其参数为等待的秒数。当 Splash 执行到此方法时,它会转而去处理其他任务,然后在指定的时间过后再回来继续处理。这里值得注意的是,Lua 脚本中的字符串拼接和 Python 不同,它使用的是

..操作符,而不是+。如果有必要,可以简单了解一下 Lua 脚本的语法,详见:http://www.runoob.com/lua/lua-basic-syntax.html另外,这里做了加载时的异常检测。

go()方法会返回加载页面的结果状态,如果页面出现 4xx 或 5xx 状态码,ok变量就为空,就不会返回加载后的图片。

Splash对象属性

args

该属性可以获取加载时配置的参数,比如 URL,如果为 GET 请求,它还可以获取 GET 请求参数;如果为 POST 请求,它可以获取表单提交的数据。Splash 也支持使用第二个参数直接作为 args,例如:function main(splash, args)

local url = args.url

--local url = splash.args.url --两者等价

endjs_enabled

Splash的 JavaScript 执行开关,可以将其配置为 true 或 false 来控制是否执行 JavaScript 代码,默认为 true。示例:function main(splash, args)

splash:go("https://www.baidu.com")

splash.js_enabled = false

local title = splash:evaljs("document.title")

return {title=title}

end此时运行结果就会抛出异常,一般来说,不用设置此属性,默认开启即可。

resource_timeout

设置加载的超时时间,单位为秒。如果设置为 0 或 nil(类似 Python 中的 None),代表不检测超时。

这里将超时时间设置为 0.1 秒。如果在 0.1 秒之内没有得到响应,就会抛出异常,示例如下:function main(splash)

splash.resource_timeout = 0.1

assert(splash:go('https://www.taobao.com'))

return splash:png()

endimages_enabled

设置图片是否加载,默认情况下是加载的。禁用该属性后,可以节省网络流量并提高网页加载速度。但是需要注意的是,禁用图片加载可能会影响 JavaScript 渲染。因为禁用图片之后,它的外层 DOM 节点的高度会受影响,进而影响 DOM 节点的位置。因此,如果 JavaScript 对图片节点有操作的话,其执行就会受到影响。另外,Splash 使用了缓存。如果一开始加载出来了网页图片,然后禁用了图片加载,再重新加载页面,之前加载好的图片可能还会显示出来,这时直接重启 Splash 即可。

禁用图片加载的示例如下:

function main(splash, args)

splash.images_enabled = false

assert(splash:go('https://www.jd.com'))

return {png=splash:png()}

endplugins_enabled

控制浏览器插件(如 Flash 插件)是否开启。默认情况下,此属性是 false,表示不开启。可以使用如下代码控制其开启和关闭:splash.plugins_enabled = true/false

scroll_position

控制页面上下或左右滚动。示例如下:function main(splash, args)

assert(splash:go('https://www.taobao.com'))

splash.scroll_position = {x=100, y=400}

return {png=splash:png()}

end

Splash对象的方法

官方文档:https://splash.readthedocs.io/en/stable/scripting-ref.html,

针对页面元素的 API 操作: https://splash.readthedocs.io/en/stable/scripting-element-object.html。

go()

用来请求某个链接,可以模拟 GET 和 POST 请求,同时支持传入请求头、表单等数据,其用法如下:ok, reason = splash:go{url, baseurl=nil, headers=nil, http_method="GET", body=nil, formdata=nil}

参数说明如下。

url:请求的 URL。baseurl:可选参数,默认为空,表示资源加载相对路径。headers:可选参数,默认为空,表示请求头。http_method:可选参数,默认为 GET,同时支持 POST。body:可选参数,默认为空,发 POST 请求时的表单数据,使用的 Content-type 为 application/json。formdata:可选参数,默认为空,POST 的时候的表单数据,使用的 Content-type 为 application/x-www-form-urlencoded。

该方法的返回结果是结果 ok 和原因 reason 的组合,如果 ok 为空,代表网页加载出现了错误,此时 reason 变量中包含了错误的原因,否则证明页面加载成功。示例如下:

function main(splash, args)

local ok, reason = splash:go{"http://httpbin.org/post", http_method="POST", body="name=Germey"}

if ok then

return splash:html()

end

endwait()

控制页面的等待时间,使用方法如下:ok, reason = splash:wait{time, cancel_on_redirect=false, cancel_on_error=true}

参数说明如下。

- time:等待的秒数。

- cancel_on_redirect:可选参数,默认为 false,表示如果发生了重定向就停止等待,并返回重定向结果。

- cancel_on_error:可选参数,默认为 false,表示如果发生了加载错误,就停止等待。

返回结果同样是结果 ok 和原因 reason 的组合。示例如下:

function main(splash)

splash:go("https://www.taobao.com")

splash:wait(2)

return {html=splash:html()}

endjsfunc()

可以直接调用 JavaScript 定义的方法,但是所调用的方法需要用双中括号包围,相当于实现了 JavaScript 方法到 Lua 脚本的转换。示例如下:function main(splash, args)

local get_div_count = splash:jsfunc([[

function () {

var body = document.body;

var divs = body.getElementsByTagName('div');

return divs.length;

}

]])

splash:go("https://www.baidu.com")

return ("There are %s DIVs"):format(

get_div_count())

end关于 JavaScript 到 Lua 脚本的更多转换细节,可以参考官方文档:https://splash.readthedocs.io/en/stable/scripting-ref.html#splash-jsfunc。

evaljs()

执行 JavaScript 代码并返回最后一条 JavaScript 语句的返回结果,使用方法如下:local title = splash:evaljs("document.title")

runjs()

执行 JavaScript 代码,与 evaljs() 的功能类似,但是更偏向于执行某些动作或声明某些方法。例如:function main(splash, args)

splash:go("https://www.baidu.com")

splash:runjs("foo = function() { return 'bar' }")

local result = splash:evaljs("foo()")

return result

endautoload()

设置每个页面访问时自动加载的对象,使用方法如下:ok, reason = splash:autoload{source_or_url, source=nil, url=nil}

参数说明如下。

- source_or_url:JavaScript 代码或者 JavaScript 库链接。

- source:JavaScript 代码。

- url:JavaScript 库链接

但是此方法只负责加载 JavaScript 代码或库,不执行任何操作。如果要执行操作,可以调用 evaljs() 或 runjs() 方法。示例如下:

function main(splash, args)

splash:autoload([[

function get_document_title(){

return document.title;

}

]])

splash:go("https://www.baidu.com")

return splash:evaljs("get_document_title()")

end使用 autoload() 方法加载某些方法库,如 jQuery,示例如下:

function main(splash, args)

assert(splash:autoload("https://code.jquery.com/jquery-2.1.3.min.js"))

assert(splash:go("https://www.taobao.com"))

local version = splash:evaljs("$.fn.jquery")

return 'JQuery version: ' .. version

endcall_later()

通过设置定时任务和延迟时间来实现任务延时执行,并且可以在执行前通过 cancel() 方法重新执行定时任务。示例如下:function main(splash, args)

local snapshots = {}

local timer = splash:call_later(function()

snapshots["a"] = splash:png()

splash:wait(1.0)

snapshots["b"] = splash:png()

end, 0.2)

splash:go("https://www.taobao.com")

splash:wait(3.0)

return snapshots

end这里设置了一个定时任务,0.2 秒的时候获取网页截图,然后等待 1 秒,1.2 秒时再次获取网页截图,第一次截图时网页还没有加载出来,截图为空,第二次网页便加载成功了。

http_get()

模拟发送 HTTP 的 GET 请求,使用方法如下:response = splash:http_get{url, headers=nil, follow_redirects=true}

参数说明如下。

- url:请求 URL。

- headers:可选参数,默认为空,请求头。

- follow_redirects:可选参数,表示是否启动自动重定向,默认为 true。

示例如下:

function main(splash, args)

local treat = require("treat")

local response = splash:http_get("http://httpbin.org/get")

return {

html=treat.as_string(response.body),

url=response.url,

status=response.status

}

endhttp_post()

模拟发送 POST 请求,多了一个参数 body,使用方法如下:response = splash:http_post{url, headers=nil, follow_redirects=true, body=nil}

示例:

function main(splash, args)

local treat = require("treat")

local json = require("json")

local response = splash:http_post{"http://httpbin.org/post",

body=json.encode({name="Germey"}),

headers={["content-type"]="application/json"}

}

return {

html=treat.as_string(response.body),

url=response.url,

status=response.status

}

endset_content()

设置页面的内容,示例如下:function main(splash)

assert(splash:set_content("<html><body><h1>hello</h1></body></html>"))

return splash:png()

endhtml()

用来获取网页的源代码,示例如下:function main(splash, args)

splash:go("https://httpbin.org/get")

return splash:html()

endpng()

用来获取 PNG 格式的网页截图,示例如下:function main(splash, args)

splash:go("https://www.taobao.com")

return splash:png()

endjpeg()

来获取 JPEG 格式的网页截图,示例如下:function main(splash, args)

splash:go("https://www.taobao.com")

return splash:jpeg()

endhar()

用来获取页面加载过程描述,示例如下:function main(splash, args)

splash:go("https://www.baidu.com")

return splash:har()

endurl()

获取当前正在访问的 URL,示例如下:function main(splash, args)

splash:go("https://www.baidu.com")

return splash:url()

endget_cookies()

获取当前页面的 Cookies,示例如下:function main(splash, args)

splash:go("https://www.baidu.com")

return splash:get_cookies()

endadd_cookie()

为当前页面添加 Cookie,用法如下:cookies = splash:add_cookie{name, value, path=nil, domain=nil, expires=nil, httpOnly=nil, secure=nil}

该方法的各个参数代表 Cookie 的各个属性。示例如下:

function main(splash)

splash:add_cookie{"sessionid", "237465ghgfsd", "/", domain="http://example.com"}

splash:go("http://example.com/")

return splash:html()

endclear_cookies()

清除所有的 Cookies,示例如下:function main(splash)

splash:go("https://www.baidu.com/")

splash:clear_cookies()

return splash:get_cookies()

endget_viewport_size()

获取当前浏览器页面的大小,即宽高,示例如下:function main(splash)

splash:go("https://www.baidu.com/")

return splash:get_viewport_size()

endset_viewport_size()

设置当前浏览器页面的大小,即宽高,用法如下:function main(splash)

splash:set_viewport_size(400, 700)

assert(splash:go("http://cuiqingcai.com"))

return splash:png()

endset_viewport_full()

设置浏览器全屏显示,示例如下:function main(splash)

splash:set_viewport_full()

assert(splash:go("http://cuiqingcai.com"))

return splash:png()

endset_user_agent()

设置浏览器的 User-Agent,示例如下:function main(splash)

splash:set_user_agent('Splash')

splash:go("http://httpbin.org/get")

return splash:html()

endset_custom_headers()

设置请求头,示例如下:function main(splash)

splash:set_custom_headers({

["User-Agent"] = "Splash",

["Site"] = "Splash",

})

splash:go("http://httpbin.org/get")

return splash:html()

endselect()

选中符合条件的第一个节点,如果有多个节点符合条件,则只会返回一个,其参数是 CSS 选择器。示例如下:function main(splash)

splash:go("https://www.baidu.com/")

input = splash:select("#kw")

input:send_text('Splash')

splash:wait(3)

return splash:png()

end这里首先访问了百度,然后选中了搜索框,随后调用了 send_text() 方法填写了文本,然后返回网页截图。

select_all()

选中所有符合条件的节点,其参数是 CSS 选择器。示例如下:function main(splash)

local treat = require('treat')

assert(splash:go("http://quotes.toscrape.com/"))

assert(splash:wait(0.5))

local texts = splash:select_all('.quote .text')

local results = {}

for index, text in ipairs(texts) do

results[index] = text.node.innerHTML

end

return treat.as_array(results)

endmouse_click()

模拟鼠标点击操作,传入的参数为坐标值 x 和 y。此外,也可以直接选中某个节点,然后调用此方法,示例如下:function main(splash)

splash:go("https://www.baidu.com/")

input = splash:select("#kw")

input:send_text('Splash')

submit = splash:select('#su')

submit:mouse_click()

splash:wait(3)

return splash:png()

end这里首先选中页面的输入框,输入了文本,然后选中 “提交” 按钮,调用了 mouse_click() 方法提交查询,然后页面等待三秒,返回截图。

Splash API调用

和 Python 程序结合使用并抓取 JavaScript 渲染的页面, Splash 提供了一些 HTTP API 接口,只需要请求这些接口并传递相应的参数即可,下面简要介绍这些接口。

render.html

此接口用于获取 JavaScript 渲染的页面的 HTML 代码,接口地址就是 Splash 的运行地址加此接口名称,例如 http://localhost:8050/render.html。Python 实现代码如下:import requests

url = 'http://localhost:8050/render.html?url=https://www.baidu.com'

response = requests.get(url)

print(response.text)此接口还可以指定其他参数,比如通过 wait 指定等待秒数。如果要确保页面完全加载出来,可以增加等待时间,例如:

url = 'http://localhost:8050/render.html?url=https://www.taobao.com&wait=5'另外,此接口还支持代理设置、图片加载设置、Headers 设置、请求方法设置,具体的用法可以参见官方文档 https://splash.readthedocs.io/en/stable/api.html#render-html。

render.png

此接口可以获取网页截图,其参数比 render.html 多了几个,比如通过 width 和 height 来控制宽高,返回的是 PNG 格式的图片二进制数据。示例如下:curl http://localhost:8050/render.png?url=https://www.taobao.com&wait=5&width=1000&height=700

Python 实现,可以将返回的二进制数据保存为 PNG 格式的图片,具体如下:

import requests

url = 'http://localhost:8050/render.png?url=https://www.jd.com&wait=5&width=1000&height=700'

response = requests.get(url)

with open('taobao.png', 'wb') as f:

f.write(response.content)详细的参数设置可以参考官网文档 https://splash.readthedocs.io/en/stable/api.html#render-png。

render.jpeg

此接口和 render.png 类似,不过它返回的是 JPEG 格式的图片二进制数据。另外,此接口比 render.png 多了参数 quality,它用来设置图片质量。

render.har

此接口用于获取页面加载的 HAR 数据,示例如下:curl http://localhost:8050/render.har?url=https://www.jd.com&wait=5

它的返回结果非常多,是一个 JSON 格式的数据,其中包含页面加载过程中的 HAR 数据。

render.json

此接口包含了前面接口的所有功能,返回结果是 JSON 格式,通过传入不同参数控制其返回结果。比如,传入 html=1,返回结果即会增加源代码数据;传入 png=1,返回结果即会增加页面 PNG 截图数据;传入 har=1,则会获得页面 HAR 数据。例如:curl http://localhost:8050/render.json?url=https://httpbin.org&html=1&har=1

更多参数设置,具体可以参考官方文档:https://splash.readthedocs.io/en/stable/api.html#render-json。

execute

此接口是最为强大的接口。前面说了很多 Splash Lua 脚本的操作,用此接口便可实现与 Lua 脚本的对接。前面的 render.html 和 render.png 等接口对于一般的 JavaScript 渲染页面是足够了,但是如果要实现一些交互操作的话,它们还是无能为力,这里就需要使用 execute 接口了。

通过 lua_source 参数传递了转码后的 Lua 脚本,通过 execute 接口获取了最终脚本的执行结果。Python 实现代码如下:

import requests

from urllib.parse import quote

lua = '''

function main(splash, args)

local treat = require("treat")

local response = splash:http_get("http://httpbin.org/get")

return {

html=treat.as_string(response.body),

url=response.url,

status=response.status

}

end

'''

url = 'http://localhost:8050/execute?lua_source=' + quote(lua)

response = requests.get(url)

print(response.text)

Splash负载均衡配置

用 Splash 做页面抓取时,如果爬取的量非常大,任务非常多,用一个 Splash 服务来处理的话,压力太大了,此时可以考虑搭建一个负载均衡器来把压力分散到各个服务器上。这相当于多台机器多个服务共同参与任务的处理,可以减小单个 Splash 服务的压力。

配置 Splash 服务

配置负载均衡

选用任意一台带有公网 IP 的主机来配置负载均衡。首先,在这台主机上装好 Nginx,然后修改 Nginx 的配置文件 nginx.conf,添加如下内容:http {

upstream splash {

least_conn;

server 41.159.27.223:8050;

server 41.159.27.221:8050;

server 41.159.27.9:8050;

server 41.159.117.119:8050;

}

server {

listen 8050;

location / {

proxy_pass http://splash;

}

}

}通过 upstream 字段定义了一个名字叫作 splash 的服务集群配置。其中 least_conn 代表最少链接负载均衡,它适合处理请求处理时间长短不一造成服务器过载的情况。不指定配置,默认以轮询策略实现负载均衡,每个服务器的压力相同。此策略适合服务器配置相当、无状态且短平快的服务使用。

另外,还可以指定权重,配置如下:upstream splash {

server 41.159.27.223:8050 weight=4;

server 41.159.27.221:8050 weight=2;

server 41.159.27.9:8050 weight=2;

server 41.159.117.119:8050 weight=1;

}最后,还有一种 IP 散列负载均衡,配置如下:

upstream splash {

ip_hash;

server 41.159.27.223:8050;

server 41.159.27.221:8050;

server 41.159.27.9:8050;

server 41.159.117.119:8050;

}服务器根据请求客户端的 IP 地址进行散列计算,确保使用同一个服务器响应请求,这种策略适合有状态的服务,比如用户登录后访问某个页面的情形。对于 Splash 来说,不需要应用此设置。

可以根据不同的情形选用不同的配置,配置完成后重启一下 Nginx 服务:

sudo nginx -s reload配置认证

现在 Splash 是可以公开访问的,如果不想让其公开访问,还可以配置认证,这仍然借助于 Nginx。可以在 server 的 location 字段中添加 auth_basic 和 auth_basic_user_file 字段,具体配置如下:http {

upstream splash {

least_conn;

server 41.159.27.223:8050;

server 41.159.27.221:8050;

server 41.159.27.9:8050;

server 41.159.117.119:8050;

}

server {

listen 8050;

location / {

proxy_pass http://splash;

auth_basic "Restricted";

auth_basic_user_file /etc/nginx/conf.d/.htpasswd;

}

}

}这里使用的用户名和密码配置放置在 /etc/nginx/conf.d 目录下,我们需要使用 htpasswd 命令创建。例如,创建一个用户名为 admin 的文件,相关命令如下:

htpasswd -c .htpasswd admin

配置完成后,重启一下 Nginx 服务。测试

利用 http://httpbin.org/get 测试即可,实现代码如下:import requests

from urllib.parse import quote

import re

lua = '''

function main(splash, args)

local treat = require("treat")

local response = splash:http_get("http://httpbin.org/get")

return treat.as_string(response.body)

end

'''

url = 'http://splash:8050/execute?lua_source=' + quote(lua)

response = requests.get(url, auth=('admin', 'admin'))

ip = re.search('(\d+\.\d+\.\d+\.\d+)', response.text).group(1)

print(ip)

使用Selenium爬取淘宝商品

Ch 7 验证码的识别

图形验证码识别

滑动验证码识别

点触验证码识别

宫格验证码识别

Ch 8 代理的使用

代理的设置

urllib

from urllib.error import URLError |

SOCKS5代理:

|

requests

import requests |

SOCKS5代理:

# pip install 'requests[socks]' |

或:

import requests |

Selenium

- Chrome认证代理:

from selenium import webdriver

proxy = '127.0.0.1:9743'

chrome_options = webdriver.ChromeOptions()

chrome_options.add_argument('--proxy-server=http://' + proxy)

chrome = webdriver.Chrome(chrome_options=chrome_options)

chrome.get('http://httpbin.org/get')

需要在本地创建一个manifest.json配置文件和background脚本来设置认证代理。运行代码之后本地会生成一个proxy_auth__plugin.zip文件来保存当前配置。from selenium import webdriver

from selenium.webdriver.chrome.options import Options

import zipfile

ip = '127.0.0.1'

port = 9743

username = 'foo'

password = 'bar'

manifest_json = """

{

"version": "1.0.0",

"manifest_version": 2,

"name": "Chrome Proxy",

"permissions": [

"proxy",

"tabs",

"unlimitedStorage",

"storage",

"<all_urls>",

"webRequest",

"webRequestBlocking"

],

"background": {

"scripts": ["background.js"]

}

}

"""

background_js = """

var config = {

mode: "fixed_servers",

rules: {

singleProxy: {

scheme: "http",

host: "%(ip)s",

port: %(port)s

}

}

}

chrome.proxy.settings.set({value: config, scope: "regular"}, function() {});

function callbackFn(details) {

return {

authCredentials: {

username: "%(username)s",

password: "%(password)s"

}

}

}

chrome.webRequest.onAuthRequired.addListener(

callbackFn,

{urls: ["<all_urls>"]},

['blocking']

)

""" % {'ip': ip, 'port': port, 'username': username, 'password': password}

plugin_file = 'proxy_auth_plugin.zip'

with zipfile.ZipFile(plugin_file, 'w') as zp:

zp.writestr("manifest.json", manifest_json)

zp.writestr("background.js", background_js)

chrome_options = Options()

chrome_options.add_argument("--start-maximized")

chrome_options.add_extension(plugin_file)

browser = webdriver.Chrome(chrome_options=chrome_options)

browser.get('http://httpbin.org/get') - PhatomJS

from selenium import webdriver

service_args = [

'--proxy=127.0.0.1:9743',

'--proxy-type=http'

]

# 认证代理

# service_args = [

# '--proxy=127.0.0.1:9743',

# '--proxy-type=http',

# '--proxy-auth=username:password'

# ]

browser = webdriver.PhantomJS(service_args=service_args)

browser.get('http://httpbin.org/get')

print(browser.page_source)

代理池的维护

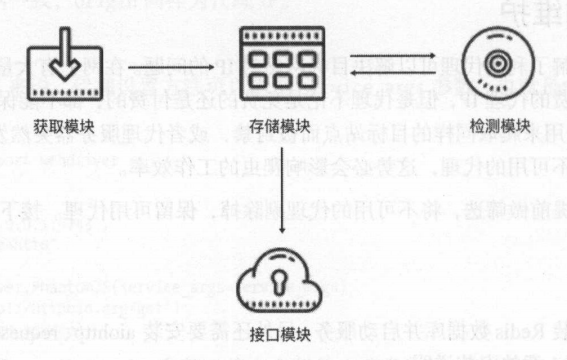

基本架构

代理池分为4个模块:存储模块、获取模块、检测模块和接口模块。

- 存储模块

存储模块使用Redis的有序集合,用来做代理的去重和状态标识,同时它也是中心模块和基础模块,将其他模块串联起来。 - 获取模块

获取模块定时从代理网站获取代理,将获取的代理传递给存储模块,并保存到数据库。 - 检测模块

检测模块定时通过存储模块获取所有代理,并对代理进行检测,根据不同的检测结果对代理设置不同的标识。 - 接口模块

接口模块通过WebAPI提供服务接口,接口通过连接数据库并通过Web形式返回可用的代理。

实现

参考项目地址:https://github.com/Python3WebSpider/ProxyPool

存储模块

对于代理池来说,有序集合中每个元素的分数可以作为判断一个代理是否可用的标志,100为最高分,代表最可用,0为最低分,代表最不可用。如果要获取可用代理,可以从代理池中随机获取分数最高的代理。

设置分数规则如下:- 分数100为可用,检测器会定时循环检测每个代理可用情况,一旦检测到有可用的代理就立即置为100,检测到不可用就将分数减1,分数减至0后代理移除。

- 新获取的代理的分数为10,如果测试可行,分数立即置为100,不可行则分数减1,分数减至0后代理移除。

import redis

from proxypool.exceptions import PoolEmptyException

from proxypool.schemas.proxy import Proxy

from proxypool.setting import REDIS_HOST, REDIS_PORT, REDIS_PASSWORD, REDIS_DB, REDIS_KEY

from proxypool.setting import PROXY_SCORE_MAX, PROXY_SCORE_MIN, PROXY_SCORE_INIT

from random import choice

from typing import List

from loguru import logger

from proxypool.utils.proxy import is_valid_proxy, convert_proxy_or_proxies

REDIS_CLIENT_VERSION = redis.__version__

IS_REDIS_VERSION_2 = REDIS_CLIENT_VERSION.startswith('2.')

class RedisClient(object):

"""

redis connection client of proxypool

"""

def __init__(self, host=REDIS_HOST, port=REDIS_PORT, password=REDIS_PASSWORD, db=REDIS_DB, **kwargs):

"""

init redis client

:param host: redis host

:param port: redis port

:param password: redis password

"""

self.db = redis.StrictRedis(host=host, port=port, password=password, db=db, decode_responses=True, **kwargs)

# 函数参数中的冒号是参数的类型建议符,告诉程序员希望传入的实参的类型。

# 函数后面跟着的箭头是函数返回值的类型建议符,用来说明该函数返回的值是什么类型。

def add(self, proxy: Proxy, score=PROXY_SCORE_INIT) -> int:

"""

add proxy and set it to init score

:param proxy: proxy, ip:port, like 8.8.8.8:88

:param score: int score

:return: result

"""

if not is_valid_proxy(f'{proxy.host}:{proxy.port}'):

logger.info(f'invalid proxy {proxy}, throw it')

return

if not self.exists(proxy):

if IS_REDIS_VERSION_2:

return self.db.zadd(REDIS_KEY, score, proxy.string())

return self.db.zadd(REDIS_KEY, {proxy.string(): score})

def random(self) -> Proxy:

"""

get random proxy

firstly try to get proxy with max score

if not exists, try to get proxy by rank

if not exists, raise error

:return: proxy, like 8.8.8.8:8

"""

# try to get proxy with max score

proxies = self.db.zrangebyscore(REDIS_KEY, PROXY_SCORE_MAX, PROXY_SCORE_MAX)

if len(proxies):

return convert_proxy_or_proxies(choice(proxies))

# else get proxy by rank

proxies = self.db.zrevrange(REDIS_KEY, PROXY_SCORE_MIN, PROXY_SCORE_MAX)

if len(proxies):

return convert_proxy_or_proxies(choice(proxies))

# else raise error

raise PoolEmptyException

def decrease(self, proxy: Proxy) -> int:

"""

decrease score of proxy, if small than PROXY_SCORE_MIN, delete it

:param proxy: proxy

:return: new score

"""

if IS_REDIS_VERSION_2:

self.db.zincrby(REDIS_KEY, proxy.string(), -1)

else:

self.db.zincrby(REDIS_KEY, -1, proxy.string())

score = self.db.zscore(REDIS_KEY, proxy.string())

#相当于"{}".format()

logger.info(f'{proxy.string()} score decrease 1, current {score}')

if score <= PROXY_SCORE_MIN:

logger.info(f'{proxy.string()} current score {score}, remove')

self.db.zrem(REDIS_KEY, proxy.string())

def exists(self, proxy: Proxy) -> bool:

"""

if proxy exists

:param proxy: proxy

:return: if exists, bool

"""

return not self.db.zscore(REDIS_KEY, proxy.string()) is None

def max(self, proxy: Proxy) -> int:

"""

set proxy to max score

:param proxy: proxy

:return: new score

"""

logger.info(f'{proxy.string()} is valid, set to {PROXY_SCORE_MAX}')

if IS_REDIS_VERSION_2:

return self.db.zadd(REDIS_KEY, PROXY_SCORE_MAX, proxy.string())

return self.db.zadd(REDIS_KEY, {proxy.string(): PROXY_SCORE_MAX})

def count(self) -> int:

"""

get count of proxies

:return: count, int

"""

return self.db.zcard(REDIS_KEY)

def all(self) -> List[Proxy]:

"""

get all proxies

:return: list of proxies

"""

return convert_proxy_or_proxies(self.db.zrangebyscore(REDIS_KEY, PROXY_SCORE_MIN, PROXY_SCORE_MAX))

def batch(self, cursor, count) -> List[Proxy]:

"""

get batch of proxies

:param cursor: scan cursor

:param count: scan count

:return: list of proxies

"""

cursor, proxies = self.db.zscan(REDIS_KEY, cursor, count=count)

return cursor, convert_proxy_or_proxies([i[0] for i in proxies])

if __name__ == '__main__':

conn = RedisClient()

result = conn.random()

print(result)

获取模块

获取模块定时从代理网站获取代理,将获取的代理传递给存储模块,并保存到数据库。# base.py

from retrying import retry

import requests

from loguru import logger

from proxypool.setting import GET_TIMEOUT

class BaseCrawler(object):

urls = []

"""

retry装饰器:

stop_max_attempt_number:在停止之前尝试的最大次数,最后一次如果还是有异常则会抛出异常,停止运行,默认为5次

wait_random_min:在两次调用方法停留时长,停留最短时间,默认为0,单位毫秒

wait_random_max:在两次调用方法停留时长,停留最长时间,默认为1000毫秒

wait_fixed:设置在两次retrying之间的停留时间

stop_max_delay:从被装饰的函数开始执行的时间点开始到函数成功运行结束或失败报错中止的时间点。单位:毫秒

retry_on_result:指定一个函数,如果指定的函数返回True,则重试,否则抛出异常退出

retry_on_exception: 指定一个函数,如果此函数返回指定异常,则会重试,如果不是指定的异常则会退出

"""

def fetch(self, url, **kwargs):

"""

获取html源码

"""

try:

kwargs.setdefault('timeout', GET_TIMEOUT)

kwargs.setdefault('verify', False)

response = requests.get(url, **kwargs)

if response.status_code == 200:

response.encoding = 'utf-8'

return response.text

except requests.ConnectionError:

return

def crawl(self):

"""

crawl main method

"""

for url in self.urls:

logger.info(f'fetching {url}')

html = self.fetch(url)

for proxy in self.parse(html):

logger.info(f'fetched proxy {proxy.string()} from {url}')

yield proxy

# daili66.py

from pyquery import PyQuery

from proxypool.schemas.proxy import Proxy

from proxypool.crawlers.base import BaseCrawler

BASE_URL = 'http://www.66ip.cn/{page}.html'

MAX_PAGE = 5

# 继承BaseCrawler

class Daili66Crawler(BaseCrawler):

"""

daili66 crawler, http://www.66ip.cn/1.html

"""

urls = [BASE_URL.format(page=page) for page in range(1, MAX_PAGE + 1)]

def parse(self, html):

"""

parse html file to get proxies

:return:

"""

doc = PyQuery(html)

trs = doc('.containerbox table tr:gt(0)').items()

for tr in trs:

host = tr.find('td:nth-child(1)').text()

port = int(tr.find('td:nth-child(2)').text())

yield Proxy(host=host, port=port)

if __name__ == '__main__':

crawler = Daili66Crawler()

for proxy in crawler.crawl():

print(proxy)检测模块

检测模块定时通过存储模块获取所有代理,并对代理进行检测,根据不同的检测结果对代理设置不同的标识。

这里使用异步请求库aiohttp来进行检测。import asyncio

import aiohttp

from loguru import logger

from proxypool.schemas import Proxy

from proxypool.storages.redis import RedisClient

from proxypool.setting import TEST_TIMEOUT, TEST_BATCH, TEST_URL, TEST_VALID_STATUS, TEST_ANONYMOUS

from aiohttp import ClientProxyConnectionError, ServerDisconnectedError, ClientOSError, ClientHttpProxyError

from asyncio import TimeoutError

EXCEPTIONS = (

ClientProxyConnectionError,

ConnectionRefusedError,

TimeoutError,

ServerDisconnectedError,

ClientOSError,

ClientHttpProxyError,

AssertionError

)

class Tester(object):

"""

tester for testing proxies in queue

"""

def __init__(self):

"""

init redis

"""

self.redis = RedisClient()

self.loop = asyncio.get_event_loop()

async def test(self, proxy: Proxy):

"""

test single proxy

:param proxy: Proxy object

:return:

"""

async with aiohttp.ClientSession(connector=aiohttp.TCPConnector(ssl=False)) as session:

try:

logger.debug(f'testing {proxy.string()}')

# if TEST_ANONYMOUS(匿名) is True, make sure that

# the proxy has the effect of hiding the real IP

if TEST_ANONYMOUS:

url = 'https://httpbin.org/ip'

async with session.get(url, timeout=TEST_TIMEOUT) as response:

resp_json = await response.json()

origin_ip = resp_json['origin']

async with session.get(url, proxy=f'http://{proxy.string()}', timeout=TEST_TIMEOUT) as response:

resp_json = await response.json()

anonymous_ip = resp_json['origin']

assert origin_ip != anonymous_ip

assert proxy.host == anonymous_ip

async with session.get(TEST_URL, proxy=f'http://{proxy.string()}', timeout=TEST_TIMEOUT,

allow_redirects=False) as response:

if response.status in TEST_VALID_STATUS:

self.redis.max(proxy)

logger.debug(f'proxy {proxy.string()} is valid, set max score')

else:

self.redis.decrease(proxy)

logger.debug(f'proxy {proxy.string()} is invalid, decrease score')

except EXCEPTIONS:

self.redis.decrease(proxy)

logger.debug(f'proxy {proxy.string()} is invalid, decrease score')

def run(self):

"""

test main method

:return:

"""

# event loop of aiohttp

logger.info('stating tester...')

count = self.redis.count()

logger.debug(f'{count} proxies to test')

cursor = 0

while True:

logger.debug(f'testing proxies use cursor {cursor}, count {TEST_BATCH}')

cursor, proxies = self.redis.batch(cursor, count=TEST_BATCH)

if proxies:

tasks = [self.test(proxy) for proxy in proxies]

self.loop.run_until_complete(asyncio.wait(tasks))

if not cursor:

break

if __name__ == '__main__':

tester = Tester()

tester.run()接口模块

接口模块通过WebAPI提供服务接口,接口通过连接数据库并通过Web形式返回可用的代理。from flask import Flask, g

from proxypool.storages.redis import RedisClient

from proxypool.setting import API_HOST, API_PORT, API_THREADED

__all__ = ['app']

app = Flask(__name__)

def get_conn():

"""

get redis client object

:return:

"""

if not hasattr(g, 'redis'):

g.redis = RedisClient()

return g.redis

def index():

"""

get home page, you can define your own templates

:return:

"""

return '<h2>Welcome to Proxy Pool System</h2>'

def get_proxy():

"""

get a random proxy

:return: get a random proxy

"""

conn = get_conn()

return conn.random().string()

def get_count():

"""

get the count of proxies

:return: count, int

"""

conn = get_conn()

return str(conn.count())

if __name__ == '__main__':

app.run(host=API_HOST, port=API_PORT, threaded=API_THREADED)

运行

pipenv shell |

程序对接实现:

import requests |

付费代理的使用

ADSL拨号代理

ADSL(Asymmetric Digital Subscriber Line,非对称数字用户环路),它的上行和下行带宽不对称,采用频分复用技术把普通的电话线分成了电话、上行和下行3个相对独立的信道,从而避免了相互之间的干扰。

ADSL通过拨号的方式上网,需要输入ADSL账号和密码,每次拨号就更换一个IP。IP分布在多个A段,如果IP都能使用,则意味着E量级可达千万。如果我们将ADSL主机作为代理,每隔一段时间主机拨号就换一个IP,这样可以有效防止IP被封禁。另外,主机的稳定性很好,代理响应速度很快。

参考项目:https://github.com/Python3WebSpider/AdslProxy

- 准备工作

- 设置代理服务器

- 动态获取IP

- 存储模块

- 拨号模块

- 接口模块

使用代理爬取微信公众号文章

参考项目:https://github.com/Python3WebSpider/Weixin

- 主要实现功能:

- 修改代理池检测链接为搜狗微信站点。

- 构造Redis爬取队列,用队列实现请求的存取。

- 实现异常处理,失败的请求重新加入队列 。

- 实现翻页和提取文章列表,并把对应请求加入队列。

- 实现微信文章的信息的提取。

- 将提取到的信息保存到MySQL。

- 构造请求

from weixin.config import *

from requests import Request

class WeixinRequest(Request):

def __init__(self, url, callback, method='GET', headers=None, need_proxy=False, fail_time=0, timeout=TIMEOUT):

# 调用父类Request的__init__()方法

Request.__init__(self, method, url, headers)

# 添加需要的额外属性

self.callback = callback

self.need_proxy = need_proxy

self.fail_time = fail_time

self.timeout = timeout - 实现请求队列

from redis import StrictRedis

from weixin.config import *

from pickle import dumps, loads

from weixin.request import WeixinRequest

class RedisQueue():

def __init__(self):

"""

初始化Redis

"""

self.db = StrictRedis(host=REDIS_HOST, port=REDIS_PORT, password=REDIS_PASSWORD)